L’intelligence artificielle (IA) a démontré son efficacité pour augmenter la productivité en entreprise. L’enjeu est désormais de lui donner les moyens d’agir de façon la plus autonome possible. Une tendance émerge alors de cette dynamique. Cette tendance, d’après Gartner, est la tendance stratégique n°1 pour 2025 : l’IA agentique.

Contrairement à l’IA traditionnelle, qui possède une autonomie limitée, les agents IA sont capables de planifier leurs actions de manière autonome, en s’appuyant sur la compréhension de leur environnement pour atteindre des objectifs définis dans leur périmètre d’actions. Cette montée en puissance est directement liée à l’intégration des LLMs (Large Language Models) dans leurs systèmes, leur permettant de traiter des entrées complexes et de lancer des actions en simulant le raisonnement humain.

L’impact attendu est considérable : d’ici 2028, l’IA agentique pourrait automatiser 15% des décisions récurrentes[1] et être intégrée à 33% des applications d’entreprise — contre quasiment aucune aujourd’hui. À l’horizon 2029, l’IA agentique pourrait résoudre de manière autonome jusqu’à 80 % des demandes courantes en service client, réduisant les coûts jusqu’à 30 %.[2]

En parallèle, la perception des risques évolue. Début 2024, Gartner a interrogé 345 responsables du risque, qui ont identifié deux principales menaces émergentes : les activités malveillantes pilotées par l’IA et la désinformation.[3]

Cette tension entre le potentiel immense de l’IA agentique et l’élargissement de la surface de risque qu’elle implique soulève une question essentielle :

« Comment les organisations peuvent-elles déployer l’IA agentique à grande échelle en toute sécurité, en équilibrant l’innovation avec la responsabilité, et l’automatisation avec le contrôle ? »

Cet article explore cette question, en soulignant les risques clés, les principes de sécurité et les conseils pratiques pour aider les RSSI et les leaders technologiques à naviguer dans la prochaine vague d’adoption de l’IA.

Un agent IA, un système d’IA autonome dans la prise de décision

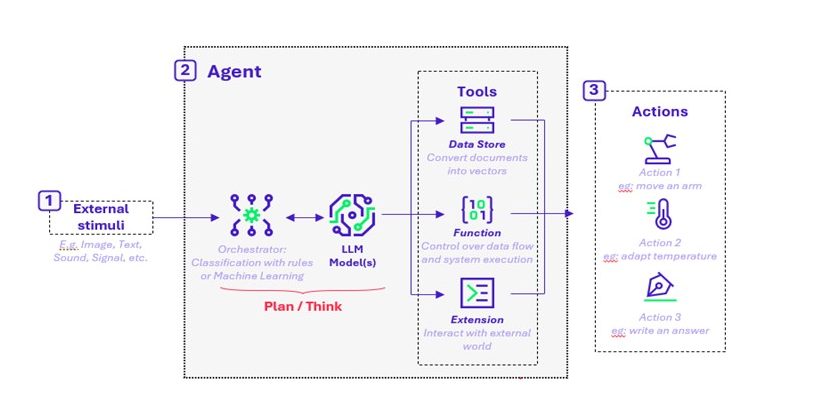

Au sein des systèmes d’IA, les agents sont conçus pour traiter les stimuli externes et y répondre par des actions spécifiques. Les capacités de ces agents peuvent varier de manière significative, en particulier selon qu’ils sont ou non alimentés par des LLM.

Les agents traditionnels suivent généralement un flux de travail basé sur des règles préprogrammées : ils reçoivent des données, les classifient et exécutent une action prédéfinie.

Figure 1 : Un diagramme montrant les différentes parties constitutives d’un agent doté de LLM, montrant 1) les stimuli externes, 2) les processus de base des agents (raisonnement et outils) et 3) les actions de l’agent.

Les agents IA introduisent une nouvelle dimension en incorporant un (ou plusieurs) LLM pour effectuer le raisonnement et la prise de décision entre la perception et l’action. Cela rend les réponses plus flexibles et adaptées au contexte et, dans de nombreux cas, permet aux agents IA de se comporter davantage comme des intermédiaires humains.à

Comme illustré dans la figure 1, un agent IA traite les informations en plusieurs étapes :

- Perception : L’agent IA reçoit des stimuli externes, tels que du texte, des images ou des sons.

- Raisonnement : Ces entrées sont traitées par une couche d’orchestration, qui les transforme en formats structurés à l’aide de règles de classification et de techniques d’apprentissage automatique. Le LLM joue ici un rôle central. Il ajoute une couche de réflexion adaptative qui permet à l’agent d’analyser le contexte, de sélectionner des outils, d’interroger des sources de données externes et de planifier des actions en plusieurs étapes.

- Action : Avec des données affinées et une couche de raisonnement appliquée, l’agent exécute des tâches complexes, souvent avec une plus grande autonomie que les systèmes traditionnels.

Cette architecture donne aux agents IA la capacité d’opérer dans des environnements dynamiques. Ils peuvent ainsi s’adapter en temps réel et collaborer avec d’autres agents ou systèmes, ce qui constitue un élément clé de différenciation par rapport à l’automatisation antérieure, plus statique.

En résumé, les agents IA dotés d’un LLM peuvent réaliser des actions plus complexes en appliquant une forme de raisonnement similaire à de l’intelligence humaine – un « raisonnement d’IA ». Les inputs sont transformés puis affinés, ce qui les rend plus puissants et plus polyvalents que des agents traditionnels qui profitent du RPA (Robotic Process Automation).

Retour d’expérience terrain sur l’usage des agents IA chez nos clients

Les entreprises ont reconnu à juste titre le potentiel de ces agents IA dans une variété de cas d’usage, allant du plus simple au plus complexe. Plongeons-nous dans le détail des cas d’usage les plus courants, en les différenciant par leur niveau d’autonomie.

Cas d’usage standard : Chatbot / agents virtuels

Les agents IA peuvent être configurés pour fournir des réponses instantanées à des questions complexes et ne répondre qu’à partir de certains référentiels d’information. Cela leur permet de guider les utilisateurs de manière fluide et efficace à travers des bibliothèques SharePoint (ou autres référentiels de documents). Agissant à la fois comme une fonction de recherche et comme un assistant, ces agents peuvent améliorer considérablement la productivité des employés en réduisant le temps passé à rechercher des informations et en garantissant aux utilisateurs un accès rapide aux données dont ils ont besoin. Par exemple, un chatbot intégré à SharePoint peut aider les employés à localiser des documents spécifiques, à comprendre les politiques de l’entreprise ou même à contribuer aux processus d’intégration en fournissant des informations et des ressources pertinentes. Ces agents ont peu d’autonomie et ne font que répondre directement aux demandes formulées par les utilisateurs.

Cas d’usage intermédiaires : Automatisation des tâches récurrentes

Les agents peuvent être utilisés pour rationaliser les tâches répétitives telles que la gestion des plannings, le traitement des demandes des clients et des transactions. Ces agents peuvent être conçus pour suivre des processus spécifiques, offrant des avantages significatifs par rapport aux humains en limitant les erreurs et en augmentant la productivité. Par exemple, un agent IA peut :

- Planifier des réunions en comparant les calendriers des participants,

- Envoyer des rappels

- Traiter les demandes courantes de service à la clientèle telles que le suivi des commandes ou la mise à jour des comptes

Cette automatisation permet d’une part de gagner du temps, et d’autre part de garantir la cohérence et la précision des tâches. En outre, en s’occupant des tâches récurrentes, les agents IA permettent aux employés de se concentrer sur des activités plus complexes et stratégiques, contribuant ainsi à accroître l’efficacité et la productivité au sein de l’organisation.

Cas d’usage avancés : Analyse de données complexes et gestion des vulnérabilités

Les agents peuvent également être utilisés pour des cas d’usage plus complexes, notamment pour la cybersécurité. Par exemple, Microsoft a récemment annoncé le lancement d’agents IA avec Security Copilot, un produit portant sur la qualification des incidents de cybersécurité.

Un cas d’usage particulièrement intéressant concerne les agents spécialisés dans la remédiation des vulnérabilités. Ces agents, au sein de Microsoft Intune, viendront :

- Surveiller les vulnérabilités des endpoints,

- Evaluer ces vulnérabilités en termes de risques et d’impacts potentiels,

- Produire une liste de mesures de mitigation classées par ordre de priorité.

Les équipes de sécurité peuvent ainsi se concentrer sur les problèmes les plus critiques, augmentant ainsi leur productivité. En automatisant l’identification et la hiérarchisation des vulnérabilités, ces agents permettent aux équipes de sécurité de s’attaquer rapidement aux menaces les plus pressantes, réduisant ainsi le risque de failles de sécurité et améliorant la posture de sécurité globale.

La promesse de rentabilité et d’automatisation intelligente est convaincante, mais elle introduit également un compromis stratégique. Les RSSI seront confrontés au défi de sécuriser des systèmes de plus en plus autonomes. En effet, en l’absence de garde-fous robustes, les organisations s’exposent à des perturbations opérationnelles, à des difficultés de gouvernance et à des atteintes à leur réputation. Il faudra également porter une vigilance accrue à la traçabilité des actions des agents, à la visibilité des assets et à la sécurité du Cloud.

Les avantages sont évidents, mais les risques aussi. Sans une approche axée sur la sécurité, l’IA agentique pourrait rapidement représenter un casse-tête handicapant plutôt qu’un atout.

Des risques majoritairement connus mais dont la vraisemblance et l’impact augmentent

Pour un système d’IA traditionnel, les surfaces de menace sont généralement limitées aux entrées, au comportement du modèle et aux sorties et à l’infrastructure. L’IA agentique introduit un nouveau niveau de complexité en matière de sécurité : ils interagissent de manière dynamique et autonome avec leur environnement. Cela couvre les échanges d’agent à agent, d’agent à humain et d’humains à agents. Ces flux peuvent être difficiles à tracer, à surveiller ou à contrôler en temps réel. Par conséquent, le périmètre de sécurité s’étend au-delà des modèles statiques pour englober les comportements et les interactions imprévisibles.

Les travaux récents de l’OWASP sur la sécurité des agents [4] mettent en valeur l’ampleur des menaces auxquelles sont confrontés les agents IA aujourd’hui. Ces risques se divisent en 3 catégories :

- Certains sont des risques traditionnels de cybersécurité (par exemple : la fuite de données et les attaques sur la supply chain),

- D’autres sont des risques généraux liés à l’IA Générative (par exemple : hallucinations, empoisonnement du modèle),

- Une troisième catégorie émergente concerne spécifiquement l’autonomie des agents à réaliser des actions dans le monde réel.

Outre les risques traditionnels, les systèmes d’IA agentique présentent de nouvelles menaces pour la sécurité, telles que l’exécution non autorisée ou involontaire de codes, ou encore le « détournement d’agent », où les agents sont manipulés à des fins malveillantes. Ces risques sont amplifiés par la manière dont de nombreux agents IA sont développés aujourd’hui.

Environ 90 % des cas d’usage actuels d’agents IA reposent sur des plateformes low-code, appréciées pour leur rapidité et leur flexibilité. Cependant, ces plateformes dépendent souvent de bibliothèques et de composants tiers, ce qui introduit d’importantes vulnérabilités dans la chaîne d’approvisionnement et élargit encore la surface d’attaque globale.

L’IA agentique marque la transition de la simple prédiction passive vers une intelligence proactive, à travers une automatisation plus sophistiquée. À mesure que les organisations mettent en place des réseaux d’agents interactifs, les systèmes deviennent de plus en plus complexes et vulnérables (multiplication des fenêtres de risques). Avec l’augmentation des interfaces et des échanges autonomes, il est crucial de poser des bases de sécurité solides dès le début. Une première étape essentielle consiste à cartographier les activités des agents pour garantir la transparence, faciliter les audits et permettre des contrôles efficaces.

Se prémunir des risques : les bonnes pratiques de sécurité à adopter dès maintenant

Pour faire face à l’évolution des menaces et des risques posés par l’IA agentique, les entreprises doivent adopter des mesures de sécurité proactives afin de garantir des opérations sécurisées et traçables.

- Cartographie des activités et audits de sécurité

Avec l’essor des agents IA autonomes et leur interaction croissante avec divers systèmes, il devient impératif de cartographier toutes leurs activités, processus, connexions et flux de données. Cette visibilité est essentielle pour détecter les anomalies et garantir le respect des politiques de sécurité.

Des audits réguliers sont cruciaux pour identifier les vulnérabilités, assurer la conformité et prévenir le phénomène de « shadow AI », où des agents opèrent sans surveillance. Les agents non autorisés peuvent exposer les systèmes à des risques significatifs, et le shadow AI, en particulier les modèles non sanctionnés, représente une menace sérieuse pour la sécurité des données. Auditer les processus décisionnels, l’accès aux données et les interactions des agents, tout en maintenant une piste d’audit immuable, renforce la responsabilité et la traçabilité globales.

Pour atténuer ces risques, les entreprises doivent adopter des politiques de gouvernance claires, sensibiliser & former ses utilisateurs, et mettre en place des stratégies de détection efficaces. Ces pratiques doivent être soutenues par des frameworks de sécurité spécialisés sur l’IA, et par des politiques de gouvernance de la donnée.

Cependant, les audits et la gouvernance ne suffisent pas. Des contrôles d’accès robustes pour les agents IA sont nécessaires pour limiter leurs actions et protéger l’intégrité du système.l’IA

2. Filtrage de l’IA

Pour éviter que l’agent n’effectue des actions inappropriées, il faut d’abord s’assurer que son système de prise de décision est protégé. L’une des mesures les plus efficaces est de filtrer les inputs et outputs potentiellement malveillants du decision-maker, souvent composé d’un orchestrateur et d’un LLM.

Il existe plusieurs moyens techniques de filtrer les inputs & outputs d’un LLM :

Filtrage par mot-clé – Efficacité faible à moyenne : Empêcher le LLM de prendre en compte toute entrée contenant des mots-clés spécifiés et de générer tout contenu contenant ces mots-clés.

- Avantage : Quick-win, en particulier sur les outputs, par exemple en empêchant un chatbot de générer des mots grossiers.

- Inconvénient : Facilement contournable via des entrées déguisées ou en exigeant des sorties déguisées. Par exemple, « p@ssword » ou « p,a,s,s,w,o,r,d » peuvent être des moyens de contourner le mot-clé « password ».

LLM-as-a-judge – Efficacité haute : Demander au LLM d’analyser les inputs et les outputs et d’identifier s’ils sont malveillants.

- Avantage : Étend l’analyse à l’ensemble de la réponse.

- Inconvénient : Peut être contourné en noyant l’agent d’informations en input, de telle sorte qu’il a du mal à traiter l’ensemble des entrées.

Classification de l’information – Efficacité très élevée : Définir des catégories de sujets auxquels le LLM a le droit de répondre ou non. Cela peut se faire par le biais d’une whitelist (le LLM ne peut répondre qu’à certaines catégories de sujets) et d’une blacklist (le LLM n’est pas autorisé à répondre à certaines catégories précises de sujets). Pour cela, on peut utiliser une IA spécialisée pour analyser chaque entrée et chaque sortie.

- Avantage : Garantit l’alignement de l’agent en ne l’empêchant de recevoir des inputs sur des sujets auxquels il ne devrait pas être en mesure de répondre.

- Inconvénient : coût élevé, car cela nécessite une analyse LLM supplémentaire.

Pour tous les systèmes d’IA générative, ces actions de filtrage doivent être effectuées pour les inputs/output des utilisateurs. Dans le cas spécifique de l’IA agentique, tous les inputs/output doivent être filtrés, y compris les interactions avec les outils que les systèmes d’IA peuvent utilisés, les bases de données qu’ils peuvent interrogées etc.

- Mesures de sécurité spécifiques à l’IA

Inclure un « Human-in-the-loop » (HITL) est essentiel pour garantir le fonctionnement responsable et sécurisé de l’IA agentique. Bien que les agents IA puissent exécuter des tâches de manière autonome, le contrôle d’un humain dans les situations à haut risque ou sensibles sur le plan éthique fournit une couche supplémentaire bienvenue de jugement et de responsabilité. Cette surveillance permet d’éviter les erreurs, les biais et les conséquences involontaires, tout en permettant aux organisations d’intervenir lorsque les actions de l’IA s’écartent des lignes directrices ou des normes éthiques. Le HITL favorise également la confiance dans les systèmes d’IA et garantit l’alignement sur les objectifs de l’entreprise et les exigences réglementaires. Pour maximiser les avantages de l’automatisation, il est essentiel d’adopter une approche hybride où IA et humains partagent les responsabilités, approche soutenue par une formation continue pour aborder la conformité et les risques inhérents.

Certaines actions peuvent être strictement interdites à l’agent, d’autres devraient nécessiter une validation humaine, et d’autres encore pourraient être effectuées sans supervision humaine. Ces actions doivent être déterminées par une analyse de risque classique, sur la base de l’impact et de l’autonomie de l’agent. En clair, on évalue l’impact de l’agent en fonction de son autonomie (et non de la probabilité du risque)

Des déclencheurs doivent être mis en place pour déterminer si et quand une validation humaine est nécessaire. On le configure directement dans le Master Prompt du LLM, et l’accès peut être restreint en utilisant un modèle IAM approprié.

3. Contrôles d’accès et IAM

Les agents IA jouent un rôle plus actif dans les workflows des entreprises. Ils doivent donc être gérés comme des identités non humaines (NHI), avec leur propre cycle de vie d’identité, leurs autorisations d’accès et leurs politiques de gouvernance. Il faut donc intégrer les agents dans les frameworks IAM existants, en appliquant la même rigueur que pour les utilisateurs humains.

La gestion des agents IA introduit de nouvelles exigences. Lorsqu’ils agissent au nom des utilisateurs finaux, les agents doivent être strictement limités aux permissions de ces utilisateurs, sans dépasser ou conserver des privilèges élevés. Pour y parvenir, les organisations doivent appliquer des principes clés de gestion des accès et des identités (IAM), à savoir :

- Accès suivant le principe du moindre privilège : Limiter les agents à l’ensemble minimum de permissions nécessaires pour accomplir des tâches spécifiques.

- Accès Just-in-time (JIT) : Fournir un accès temporaire et contextuel afin de réduire les privilèges permanents et l’exposition.

- Séparation des tâches et habilitations limitées : Définir des limites claires entre les rôles et empêcher les escalades de privilèges non autorisées.

Pour renforcer davantage les contrôles, les équipes de sécurité devraient mettre en place une détection des anomalies en temps réel afin de surveiller le comportement des agents, signaler les violations de politiques et remédier ou escalader automatiquement les problèmes lorsque nécessaire. L’accès aux données sensibles doit également être strictement limité. Les violations doivent entraîner une révocation immédiate des privilèges, et des listes de blocage doivent être utilisées pour empêcher les modèles ou points d’accès malveillants connus.

En fin de compte, bien que les contrôles techniques soient essentiels, ils doivent être soutenus par une supervision humaine et des mécanismes de gouvernance, en particulier lorsque les agents opèrent dans des contextes à fort impact ou sensibles. La gestion des identités et des accès pour les agents IA doit évoluer en parallèle avec l’autonomie croissante de ces systèmes et leur intégration dans des fonctions critiques de l’entreprise.

4. Gestion des crises IA et Redteam

Bien que les contrôles spécifiques à l’IA soient essentiels, les mesures traditionnelles comme la gestion de crise doivent également s’étendre au domaine de l’IA. À mesure que les cyberattaques deviennent plus sophistiquées, les entreprises devraient envisager des stratégies de gestion de crise en cas de défaillance ou de compromission de l’IA. Il est crucial de s’assurer que toutes les équipes, des équipes de recherche IA aux équipes de sécurité, soient prêtes à réagir rapidement et efficacement afin de minimiser les perturbations.

Exemple de plan d’action pour les RSSI

Cette année, les RSSI seront exposés à des menaces accrues introduites par l’IA agentique, ainsi qu’à une pression réglementaire supplémentaire par des réglementations complexes telles que DORA, NIS 2 et l’AI Act. Les RSSI et les directeurs techniques devront collaborer étroitement : les RSSI devront superviser le déploiement sécurisé des systèmes d’IA pour s’assurer que les interactions avec les agents sont soigneusement cartographiées et sécurisées afin de préserver la sécurité de leurs organisations, de leur personnel et de leurs clients.

Premières pistes d’actions sécurité pour les RSSI :

- Limiter l’accès des agents IA en appliquant des contrôles d’accès stricts et en s’alignant sur les politiques IAM existantes.

- Surveiller le comportement des agents en suivant leur activité et en menant des audits réguliers pour identifier les vulnérabilités.

- Filtrer les inputs et les outputs de l’agent pour s’assurer que le decision-maker ne lance pas d’action involontaire.

- S’assurer de la supervision d’un human-in-the-loop cohérente, afin de valider les résultats de l’IA pour les décisions/tâches critiques.

- Fournir une formation de sensibilisation à l’IA agentique pour éduquer les utilisateurs sur les risques, les meilleures pratiques de sécurité et l’identification des attaques potentielles.

- Auditer l’agent, via du redteaming, afin d’identifier les faiblesses potentielles.

- Etablir un RACI en cas de mauvais fonctionnement de l’agent : malgré toutes les mesures de sécurité, l’IA fonctionne selon des principes probabilistes plutôt que déterministes. Cela signifie que l’agent peut occasionnellement se comporter de manière inappropriée.

- Préparez-vous aux crises liées à l’IA en entamant des discussions avec les équipes concernées afin de garantir une réponse coordonnée en cas d’incident.

Au cours des dernières années, chez Wavestone, nous avons observé une augmentation significative de la maturité des clients en matière de sécurité de l’IA. De nombreuses organisations ont déjà mis en place des processus robustes pour évaluer la sensibilité des initiatives d’IA et gérer les risques associés. Ces premiers efforts se sont avérés payants : nous avons observé une réduction de l’exposition aux menaces et un renforcement de la gouvernance des systèmes d’IA.

Bien que l’IA agentique ne réécrive pas fondamentalement le manuel de sécurité de l’IA, elle introduit un changement significatif dans le paysage des risques. Sa nature intrinsèquement autonome et interconnectée augmente à la fois l’impact et la probabilité de certaines menaces. La complexité de ces systèmes peut être difficile à gérer au début, mais elle est maîtrisable. Avec une compréhension claire de ces dynamiques et l’émergence de nouvelles normes de marché et de protocoles de sécurité, l’IA agentique peut s’accomplir pleinement, dans des conditions sécurisées, et assurer un gain de productivité conséquent.

Dans cette mer de menaces en perpétuel changement, notre cap reste clair : accompagner les RSSI et leurs équipiers pour qu’ils avancent avec sérénité.

Références

[1] Orlando, Fla., Gartner Identifies the Top 10 Strategic Technology Trends for 2025, October 21, 2024. https://www.gartner.com/en/newsroom/press-releases/2024-10-21-gartner-identifies-the-top-10-strategic-technology-trends-for-2025

[2] Stamford, Conn., Gartner Predicts Agentic AI Will Autonomously Resolve 80% of Common Customer Service Issues Without Human Intervention by 2029, March 5, 2025. https://www.gartner.com/en/newsroom/press-releases/2025-03-05-gartner-predicts-agentic-ai-will-autonomously-resolve-80-percent-of-common-customer-service-issues-without-human-intervention-by-20290

[3] Stamford, Conn. Gartner Survey Shows AI-Enhanced Malicious Attacks Are a New Top Emerging Risk for Enterprises, May 22, 2024. https://www.gartner.com/en/newsroom/press-releases/2024-05-22-gartner-survey-shows-ai-enhanced-malicious-attacks-are-new0

[4] OWASP, OWASP Top 10 threats and mitigation for AI Agents, 2025. OWASP-Agentic-AI/README.md at main · precize/OWASP-Agentic-AI · GitHub

Merci à Leina HATCH pour son aide précieuse dans la rédaction de cet article.