Un deepfake est un type de contenu synthétique apparu pour la première fois en 2017, reposant sur l’intelligence artificielle, pour créer ou falsifier du texte, des images, des vidéos et des audios de manière très réaliste. Les technologies associées étaient initialement utilisées à des fins de divertissement ou perçues comme des outils de démonstration technologique d’avenir. Mais aujourd’hui, leur détournement à des fins malveillantes éclipse cet usage primaire, les présentant comme une menace émergente et un défi majeur pour la confiance numérique.

Ces utilisations malveillantes peuvent être réparties en 3 grandes catégories :

- Désinformation et phishing amélioré : des vidéos falsifiées portant un discours travaillé peuvent être exploitées pour manipuler l’opinion publique, influencer des débats politiques ou diffuser de fausses informations. Le discours de la vidéo poussera par exemple la cible à cliquer sur des liens de phishing. Nous avons déjà vu par le passé de telle usurpation d’identité ciblant des personnalités publiques ou des PDG d’entreprises pour inciter à de faux investissement par exemple.

- Fraude au président et ingénierie sociale : les attaques connues de « scam » téléphonique ou de fraude au président deviennent plus difficile à détecter et éviter si un attaquant imite la voix d’un dirigeant pour valider un transfert bancaire ou usurper une identité complète (visage et voix) pour accéder à des informations sensibles. Ces usurpations d’identité en direct, notamment en visioconférence, ont déjà causé de grands dégâts financiers comme ce fut le cas à Hong Kong début 20241.

- Usurpation d’identité pour contourner les solutions de KYC2 : de plus en plus d’applications, notamment dans le domaine bancaire, utilise des processus de vérification d’identité pour l’utilisateur en analysant le visage de celui-ci en direct. Une modification numérique de l’image du visage envoyée à l’application peut permettre à un acteur malveillant de se faire passer pour une autre personne lors de la vérification d’identité.

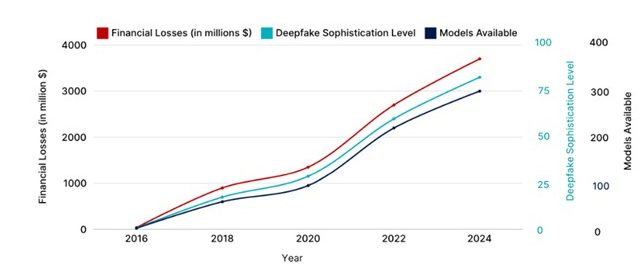

Directement lié à l’évolution exponentielle de l’intelligence artificielle générative ces dernières années, le nombre de modèles disponibles pour générer des deepfakes ainsi que leur sophistication est en forte hausse. Il est de plus en plus courant que les entreprises subissent de telles attaques (comme l’atteste notre dernier rapport annuel CERT-W4) et il devient de plus en plus difficile de les détecter et contrer.

Figure 1 – Augmentation des technologies deepfakes et des pertes financières en résultant

L’humain demeure la première cible et restait donc le premier rempart du système d’information pour lutter contre ce type d’attaques. Cependant, nous avons observé une évolution importante de la maturité de ces technologies sur cette dernière année et il devient de plus en plus difficile de distinguer le vrai du faux à l’œil nu.

Après avoir accompagné de nombreuses entreprises dans la formation et la sensibilisation de leurs collaborateurs à ces menaces, il nous a paru essentiel de mener une étude analysant l’outillage qui permettrait de renforcer leur défense. Disposer de solutions de détection de deepfakes fiables n’est plus seulement un enjeu technique : c’est une nécessité pour protéger le SI contre les intrusions, maintenir la confiance dans les échanges numériques et préserver la réputation des personnalités et des entreprises.

Notre Radar des solutions de détection des deepfakes présente un panorama d’une trentaine d’acteurs que nous avons pu rencontrer. Ceux-ci proposent des solutions variées que nous avons rigoureusement évaluées afin d’identifier les premières tendances de ce marché naissant.

Pour mener ces tests techniques, certains acteurs ont mis à notre disposition une ou plusieurs versions de leur solution dans des environnements variés reflétant le déploiement habituel des solutions chez leurs clients. Nous avons alors construit une base de données de multiples contenus deepfake de typologie variée : type de média (audio seul, image, vidéo, interaction live) ; format (taille de l’échantillon, durée, extension) et outillage deepfake utilisé pour générer ces échantillons :

Pour extraire au mieux de ces tests les tendances du marché, nous avons considéré 3 critères d’évaluation distincts :

- La performance (capacité de détection des deepfakes, véracité des résultats sur les faux positifs, temps de réponse…)

- Le déploiement (facilité d’intégration dans un environnement client, aide au déploiement et documentation)

- L’expérience utilisateur (compréhension des résultats, facilité d’utilisation de l’outil…)

Un marché émergeant qui a déjà fait ses preuves en conditions réelles

Deux technologies différentes pour atteindre le même objectif

Nous avons en premier lieu catégorisé les différentes solutions proposées selon le type de contenu détecté :

- 56% des solutions détectent à partir de données visuelles du média (image, vidéo)

- 50% de solutions optent pour une détection à partir de données audio (fichier audio simple ou audio d’une vidéo)

Cette répartition homogène du choix de contenu à traiter nous permet d’étudier la performance de l’une ou l’autre des technologies. Si la plupart des solutions développées se repose sur des modèles d’intelligence artificielle entrainés pour classifier les contenus générés par de l’IA, le traitement d’un fichier visuel (type photo) ou d’un fichier audio (type mp3) diffère grandement dans les types modèles d’IA utilisés. Nous pourrions donc nous attendre à des différences de performance sur ces deux technologies.

Cependant, nos tests techniques montrent que la précision des solutions est relativement semblable que ce soit pour celles traitant de l’image ou de l’audio.

|

92,5% Des images ou vidéos deepfake ont été détectées comme malveillantes par les solutions traitant les images |

VS |

96% Des sources audio deepfake ont été détectées comme malveillantes par les solutions traitant les audios |

Il nous a paru également important de recenser les fournisseurs de solutions les plus matures qui cherchent maintenant à développer une capacité de détection des deepfakes sur des flux audio ou vidéo en direct (avec moins de 10 secondes de traitement de la source), sources d’attaques les plus dangereuses aujourd’hui.

|

19% |

Des solutions proposent une détection en direct des deepfakes, intégrés dans les logiciels de visioconférence ou sur les appareils |

Celles-ci, traitant majoritairement l’audio, ont obtenu un score de précision de 73% des deepfake détectés comme tel. Cela montre la marge de progression possible pour ces jeunes acteurs dans la détection des attaques à la pointe de la technologie en direct.

Du PoC au déploiement at scale, un pas déjà franchi par certains

La maturité des solutions varie également sur notre radar. Si certains fournisseurs sont des start-ups émergeantes pour répondre à ce besoin spécifique, d’autres n’en sont pas à leur premier produit sur le marché. En effet, certaines entreprises rencontrées présentaient déjà des activités sur des domaines tels que l’identification biométrique, outil d’intelligence artificielle et même générateur de contenu multimédia par IA ! Ces acteurs avaient donc une connaissance et expérience suffisante pour proposer à leur client un service packagé, déployable sur un large périmètre ainsi qu’un support post-déploiement.

Néanmoins les startups plus jeunes gagnent également en maturité sur leurs services et permettent aussi d’aller au-delà de la phase de PoC en proposant aux entreprises différentes possibilités de déploiement :

- La requête API, intégrable dans d’autres softwares, reste la façon privilégiée d’appeler les services permettant la détection des deepfake ;

- Des plateformes GUI6 complètes en SaaS, certaines d’entre elles ayant déjà été déployées on-premise dans certains contextes, notamment en secteur bancaire ou de l’assurance ;

- Des conteneurs dockers on-device, permettant notamment d’ajouter des plug-ins à des périphériques audio, vidéo ou à des logiciels de vidéoconférence pour une intégration adaptée aux besoins spécifiques de détection.

Les cas d’usages des solutions de détection de deepfakes : tendances et évolution

Des cas d’usages spécifiques aux besoins business critiques à protéger

Pour s’adapter et répondre aux attentes et besoins du marché, les éditeurs se sont spécialisés pour répondre à des cas d’usage précis. En plus de la réponse « deepfake ou contenu original ? », certains éditeurs développent et proposent des fonctionnalités supplémentaires pour cibler un usage spécifique de leur solution.

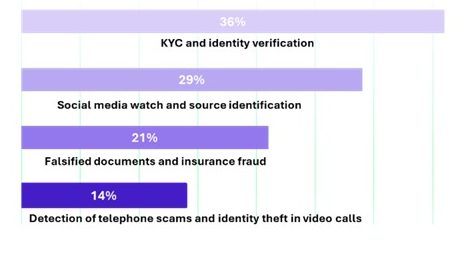

Figure 2 – Répartition des solutions selon le cas d’usage business ciblé

Nous avons regroupé les différentes propositions des éditeurs en grandes catégories nous permettant de comprendre les tendances du marché :

- KYC et vérification d’identité : dans les processus d’onboarding bancaire ou d’ouverture de compte en ligne, la détection de deepfake permet de distinguer une véritable vidéo d’un usager d’une imitation générée par IA. Cela protège les institutions financières contre l’usurpation d’identité et le blanchiment d’argent. Ces solutions vont notamment pouvoir donner des scores de « liveness » ou de taux de correspondance à la personne devant être identifiée pour affiner la détection.

- Veille sur les réseaux sociaux et identification des sources : Pour éviter que des faux médias ou informations ne viennent s’attaquer à la réputation de leur client, certains éditeurs de solution ont déployé des veilles sur les réseaux sociaux ou des outils d’analyse de contenu multimédia en pièce jointe de mail pour réagir rapidement. Les fonctionnalités de ces solutions permettent notamment de comprendre comment et par quel modèle de deepfake ces contenus malveillants ont été produits pour aider à tracer la source de l’attaque.

- Documents falsifiés et fraude à l’assurance : un certain nombre d’acteurs se sont tournés vers la lutte contre la fraude à l’assurance ou aux fausses pièces d’identité. Leurs solutions cherchent alors à détecter des altérations dans des pièces justificatives ou des photos de sinistres en mettant en évidence quelles parties de l’image d’origine ont été modifiées.

- Détection des arnaques téléphoniques et usurpation d’identité en appel vidéo : ces types d’attaque se multiplient et reposent sur la création d’imitations réalistes de la voix ou du visage d’un dirigeant notamment pour tromper des collaborateurs et obtenir des virements ou informations sensibles. La majorité des systèmes de détection ciblant ces attaques ont développé des capacités d’intégration complète dans les logiciels d’appel vidéo ou sur les cartes sons des appareils à protéger.

Ainsi, chaque solution est pensée avec des fonctionnalités spécifiques, alignée sur les besoins du marché pour maximiser la pertinence et l’efficacité opérationnelle des solutions de détection.

L’open-source comme initiateur, les solutions propriétaires pour prendre le relai

Nous avons parlé jusqu’alors de solutions majoritairement propriétaires. Cependant, l’approche open-source existe bel et bien dans ce domaine. Ces initiatives jouent un rôle important dans la recherche académique et l’expérimentation, mais elles sont souvent moins performantes et moins robustes face à des deepfakes sophistiqués.

Si certaines proposent de très bons résultats sur des bancs de tests maitrisés (jusqu’à 90% de performance de détection7), les solutions propriétaires proposées par des éditeurs spécialisés offrent en général de meilleures performances en production. Elles se distinguent aussi par l’accompagnement : mises à jour régulières, support technique et services de maintenance, indispensables pour des environnements critiques comme la finance, l’assurance ou le secteur publique. Cette différence crée progressivement un écart entre la recherche open source et les offres commerciales, où la fiabilité et l’intégration en environnements complexes deviennent des arguments clés.

Les faux positifs, la limite qu’il reste à repousser

Beaucoup d’éditeurs mettent en avant leur capacité de performance de détection de contenu deepfake. Il nous a paru important de prolonger les tests pour comprendre les performances de ces solutions sur les faux positifs : les contenus réels sont-ils détectés comme du contenu naturel ou comme du contenu deepfake ?

Les évaluations que nous avons menées sur plusieurs solutions de détection mettent en lumière des résultats contrastés selon les types de contenus.

- Pour l’image et la vidéo : près de 40 % des solutions testées rencontrent encore des difficultés à gérer correctement les faux positifs. Sur ces solutions, nous pouvons obtenir entre 50% et 70% des images réelles analysées considérées comme deepfake. Cela limite alors leur fiabilité notamment si elles sont soumises à de nombreux contenus.

- Sur le volet audio, les solutions se distinguent avec des performances plus solides sur les faux positifs : seulement 7%. Seuls quelques échantillons particulièrement altérés (mais sans IA) ou de mauvaise qualité ont été détectés comme deepfake par certaines solutions.

Pour pallier ces problèmes, certains éditeurs cherchent à combiner le traitement image/vidéo et audio. Aujourd’hui, ces deux modalités demeurent le plus souvent traitées comme deux scores séparés, conservant généralement le score tendant le plus vers le contenu généré par IA. Des pistes d’amélioration sont en cours chez certains éditeurs pour se servir de ces deux scores avec plus de complémentarité pour réduire les faux positifs.

Quel futur pour la détection de deepfakes?

Les solutions actuelles ont démontré leur efficacité dans la plupart des conditions existantes aujourd’hui dans l’écosystème d’attaques deepfake. Cependant, dans un contexte où ces technologies et leurs utilisations se réinventent rapidement, les éditeurs vont devoir faire face à deux défis majeurs.

Le premier axe concerne l’efficacité face aux outils génératifs inconnus : si la maîtrise des technologies de génération les plus courantes est désormais bien établie, les écarts de performance apparaissent lorsqu’il s’agit de détecter des contenus produits par des technologies émergentes, moins documentées et plus opaques.

Le second axe clé réside dans la détection en temps réel. À ce jour, seulement 19 % des solutions intègrent de telles fonctionnalités, et même parmi celles-ci la performance observée demeure insuffisante pour répondre à ces besoins qui seront les vraies préoccupations de demain. Pour contraster ces propos, des progrès notables apparaissent déjà du côté de la détection audio, qui se profile comme une avancée prometteuse pour renforcer la sécurité dans des scénarios critiques de phishing ou fraude au président via appel audio deepfake.

La maturité du marché dans ces technologies de pointe s’accélère, et tout laisse à penser que les solutions de détection rattraperont rapidement leur retard face aux dernières avancées en matière de création de deepfakes. Les prochaines années seront déterminantes pour voir émerger des outils plus fiables, plus rapides et mieux intégrés aux besoins métiers.