Le marché de la sécurité de l’IA entre dans une nouvelle phase

Après une phase d’effervescence et d’exploration, le marché des solutions de sécurité de l’IA entre désormais dans une phase de consolidation. Le secteur voit émerger des dynamiques de maturité que nous avons captées à travers l’évolution de notre radar des solutions.

Depuis la publication de notre précédente édition,

(https://www.wavestone.com/fr/insight/radar-2024-des-solutions-de-securite-ia/),

5 acquisitions majeures ont eu lieu :

- Cisco a acquis Robust Intelligence en septembre 2024

- SAS a acquis Hazy en novembre 2024

- H Company a acquis Mithril Security fin 2024

- Nvidia a acquis Gretel en mars 2025

- Palo Alto a annoncé son intention d’acquérir ProtectAI en avril 2025

Ces mouvements traduisent une volonté claire des grands acteurs de sécuriser leurs positions en absorbant des startups technologiques clés.

En parallèle, notre nouvelle cartographie recense 94 solutions, contre 88 dans l’édition d’octobre 2024. Quinze nouvelles solutions font leur entrée dans le radar, tandis que huit ont été retirées. Ces sorties s’expliquent principalement par des abandons ou des pivots stratégiques : certaines startups n’ont pas réussi à trouver leur marché, tandis que d’autres choisissent de réorienter leur positionnement, en capitalisant sur leur expertise en intelligence artificielle pour adresser des enjeux dépassant le cadre strict de la cybersécurité.

Enfin, un changement de paradigme s’opère : les solutions ne se limitent plus à un empilement de briques techniques, mais convergent vers des architectures de défense intégrées, conçues pour répondre durablement aux exigences des grandes organisations. L’interopérabilité, la scalabilité et l’alignement avec les besoins des grandes entreprises deviennent les nouveaux standards. La cybersécurité de l’IA s’affirme désormais comme une stratégie globale, et non plus comme une somme de réponses ponctuelles.

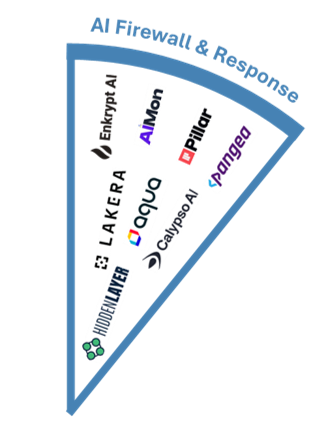

Pour refléter cette évolution, nous avons fait évoluer notre propre grille de lecture en créant une nouvelle catégorie, AI Firewall & Response, qui résulte de la fusion de nos catégories Machine Learning Detection & Response et Secure Chat/LLM Firewall.

Le meilleur ou l’essentiel ? Le dilemme de l’intégration

Avec l’intégration croissante de briques de sécurité IA dans les offres des principaux fournisseurs Cloud (Microsoft Azure, AWS, Google Cloud), une question stratégique émerge :

Faut-il privilégier des solutions expertes ou s’appuyer sur les capacités natives des hyperscalers ?

- Les solutions spécialisées offrent une profondeur technique et une couverture ciblée, en complément d’une sécurité existante.

- Les briques intégrées sont plus faciles à déployer, interopérables avec l’infrastructure existante, et souvent suffisantes pour des usages standard.

Il ne s’agit pas ici de trancher, mais d’éclairer les possibilités. Voici un aperçu de certains leviers de sécurité activables via les offres des hyperscalers.

Filtrage

Les fournisseurs Cloud intègrent désormais des filtres de sécurité pour interagir avec les IA de manière plus sûre. Objectif : détecter ou bloquer les contenus indésirables ou dangereux. Mais ces dispositifs vont bien plus loin que la simple modération : ils jouent un rôle clé dans la défense contre les attaques adversariales, comme les prompt injections ou les jailbreaks, qui visent à détourner le comportement du modèle.

Evaluation de la robustesse

Il s’agit ici d’évaluer dans quelle mesure un modèle IA résiste à des perturbations, erreurs, ou attaques ciblées. Cela couvre :

- L’exposition aux attaques adversariales,

- La sensibilité aux données bruitées,

- La stabilité face à des prompts ambigus,

- La résilience aux tentatives d’extraction ou de manipulation.

Ces outils offrent une première évaluation automatisée, utile en amont des mises en production.

Confidential Computing

Cette approche va au-delà de la sécurité des données au repos ou en transit : elle vise à protéger les calculs en cours, grâce à l’utilisation d’enclaves sécurisées. Elle garantit un haut niveau de confidentialité tout au long du cycle de vie des modèles IA, des données sensibles ou des algorithmes propriétaires, en empêchant tout accès non autorisé.

IA agentique : un risque transversal, une sécurité distribuée

Parmi les tendances qui concentrent l’attention des experts en cybersécurité, l’IA agentique occupe une place croissante. Ces systèmes capables de prendre des décisions, de planifier des actions et d’interagir avec des environnements complexes cumulent en réalité deux types de vulnérabilités :

- Celles des systèmes informatiques traditionnels avec lesquels l’IA va interagir plus ou moins bien,

- Et celles propres aux modèles d’IA et aux orchestrateurs d’agents associés.

Résultat : une surface d’attaque élargie, et des conséquences potentiellement critiques. Mal configuré, un agent pourrait accéder à des fichiers sensibles, exécuter du code malveillant ou provoquer des effets de bord inattendus dans un environnement de production.

À cela s’ajoute un facteur nouveau majeur : l’émergence du Model Context Protocol (MCP), un standard en cours de diffusion qui permet aux LLM d’interagir de manière standardisée avec des outils et services tiers (mail, calendrier, drive…). S’il facilite la montée en puissance des agents, il introduit aussi de nouveaux vecteurs d’attaque :

- Exposition ou vol de jetons d’authentification,

- Absence de mécanismes d’authentification des outils,

- Possibilité d’attaques par injection de prompt dans des contenus apparemment anodins,

- Ou encore compromission d’un serveur MCP donnant accès à l’ensemble des services connectés.

Au-delà des failles techniques, l’imprévisibilité comportementale des agents pose un défi inédit. Parce que l’action découle directement d’une sortie de modèle IA, une erreur d’interprétation ou de planification peut entraîner une dérive majeure par rapport à l’intention initiale.

Dans ce contexte, la sécurisation de l’agentique ne relève pas d’une catégorie unique. Elle nécessite une couverture transversale, mobilisant toutes les briques de notre radar : évaluation de robustesse, monitoring, protection de la donnée, explicabilité, filtrage et gestion des risques.

Et c’est précisément ce que nous observons sur le marché : les premières réponses à la sécurisation de l’IA agentique ne viennent pas de nouveaux acteurs, mais de fonctionnalités additionnelles intégrées aux solutions existantes. Un enjeu émergent, certes, mais que les acteurs du marché commencent déjà à prendre en charge à travers des évolutions fonctionnelles intégrées aux solutions existantes.

Nos recommandations : quelles briques de sécurité IA implémenter en priorité ?

Au regard de l’évolution des menaces, de la complexité croissante des systèmes IA (notamment des agents) et de la diversité des solutions disponibles, nous recommandons de concentrer les efforts sur trois grandes catégories de sécurité, qui se complètent mutuellement.

AI Firewall & Response : une surveillance continue pour éviter la dérive

Le monitoring des systèmes IA est devenu incontournable. En effet, une IA peut évoluer de manière imprévisible, se dégrader dans le temps, ou commencer à générer des réponses problématiques sans que cela soit immédiatement détecté. Ce point devient particulièrement critique avec les IA agentiques, dont les décisions autonomes peuvent entraîner des répercussions opérationnelles majeures en cas de dérive non maîtrisée.

Face à cette volatilité, il est essentiel de pouvoir détecter les signaux faibles en temps réel (tentatives de prompt injection, dérives comportementales, biais émergents, etc). C’est pourquoi il est préférable de s’appuyer sur des solutions expertes dédiées à la détection et à la réponse, qui disposent d’analyses spécifiques et de mécanismes d’alerte adaptés à ces menaces.

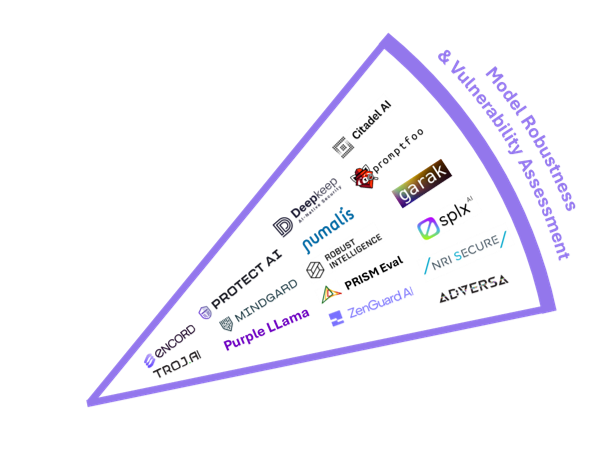

Model Robustness & Vulnerability Assessment : tester pour prévenir

Avant de mettre en production un modèle, il est crucial d’évaluer sa robustesse et sa résistance aux attaques. Cela passe par du model testing classique, mais aussi par des approches plus offensives comme le AI Red Teaming, qui consiste à simuler des attaques réelles pour identifier les failles exploitables par un attaquant.

Là encore, les enjeux sont amplifiés dans le cas de l’IA agentique : les conséquences d’un comportement non anticipé peuvent être lourdes, tant en termes de sécurité que de conformité.

Les solutions du marché apportent ici une forte valeur ajoutée. Elles permettent d’automatiser les tests, de rester à jour sur les vulnérabilités les plus récentes, et parfois même de collecter des preuves utiles dans un cadre réglementaire (par exemple, dans la perspective de l’AI Act). Le coût et le temps nécessaires pour développer ces capacités en interne étant élevés, l’externalisation via des outils spécialisés est souvent plus efficace.

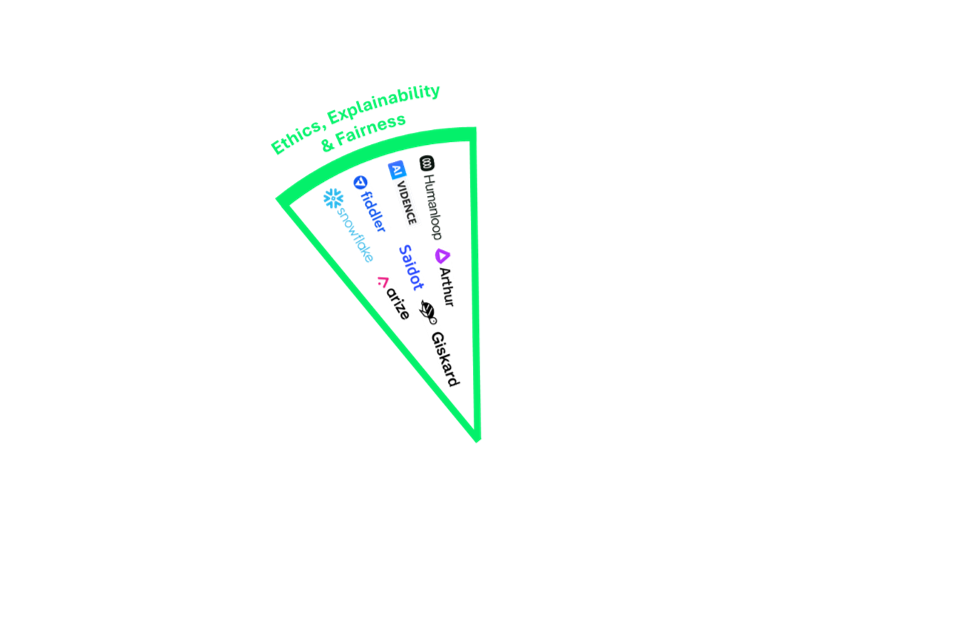

Ethics, Explainability & Fairness : prévenir les biais et les dérives algorithmiques

Enfin, les dimensions d’éthique, de transparence et de non-discrimination doivent être intégrées dès la conception des systèmes IA. Cela implique de tester régulièrement les modèles pour identifier des biais involontaires ou des décisions difficiles à expliquer.

Là encore, les agents IA posent des défis supplémentaires : ils prennent des décisions de manière autonome, dans des environnements changeants, avec un raisonnement parfois opaque. Comprendre pourquoi un agent a agi d’une certaine façon devient alors crucial pour prévenir les erreurs ou les injustices.

Des outils spécialisés permettent d’auditer les modèles, de mesurer leur équité et leur explicabilité, et d’aligner les systèmes sur des référentiels éthiques reconnus. Ces solutions offrent aussi des cadres de test actualisés, difficilement maintenables en interne, et permettent ainsi de garantir une IA à la fois performante et responsable.

Conclusion : construire une stratégie de sécurité adaptée à l’IA

À mesure que l’intelligence artificielle s’intègre profondément dans les opérations des grandes entreprises, sa sécurisation ne relève plus du choix — c’est désormais un impératif stratégique. L’évolution rapide des menaces, l’émergence de l’IA agentique et la complexité croissante des modèles imposent un changement de posture : il faut passer de mesures réactives à des stratégies de sécurité intégrées et proactives.

Les organisations doivent dépasser les approches fragmentées et adopter un cadre global combinant tests de robustesse, surveillance continue et garanties éthiques. L’apparition d’architectures de défense intégrées et la convergence des catégories de sécurité de l’IA témoignent d’un marché en pleine maturité, prêt à soutenir des déploiements à l’échelle entreprise.

L’enjeu est clair : identifier le bon équilibre entre outils spécialisés et capacités natives des hyperscalers, prioriser une couverture transversale, et garantir que les systèmes IA restent fiables, résilients et alignés avec les objectifs métiers.

Nous remercions Anthony APRUZZESE pour sa précieuse contribution à la rédaction de cet article.