L’essor de l’IA générative et des modèles de langage (LLM) tels que ChatGPT a bouleversé les pratiques numériques. De plus en plus d’entreprises choisissent de déployer des applications intégrant ces modèles, mais cette intégration s’accompagne de nouvelles vulnérabilités, identifiées par l’OWASP dans son LLM Top 10 2025. Face à ces risques et à de nouvelles réglementations comme l’AI Act, des solutions spécialisées, appelées guardrails (garde-fous en français), ont émergé pour sécuriser les interactions avec les LLM et deviennent essentielles pour garantir la conformité et la sécurité de ces applications.

Le défi du choix des guardrails

Du fait de la multiplication des solutions de protection pour les applications d’IA, les organisations sont confrontées à un défi: sélectionner des moyens de protection permettant de réduire efficacement les risques sans compromettre l’expérience utilisateur ou la gestion de l’application.

La sélection des guardrails ne se limite pas à bloquer les prompts malveillants, elle nécessite de trouver un équilibre entre la précision de la détection, les faux positifs, la latence et la capacité à adapter le filtrage au contexte spécifique de l’application, aux sources de données et à l’exposition aux menaces de chaque application. Dans la pratique, aucune solution unique ne répond aussi bien à tous les cas d’utilisation, ce qui fait du choix de ces solutions une décision contextuelle et axée sur les risques.

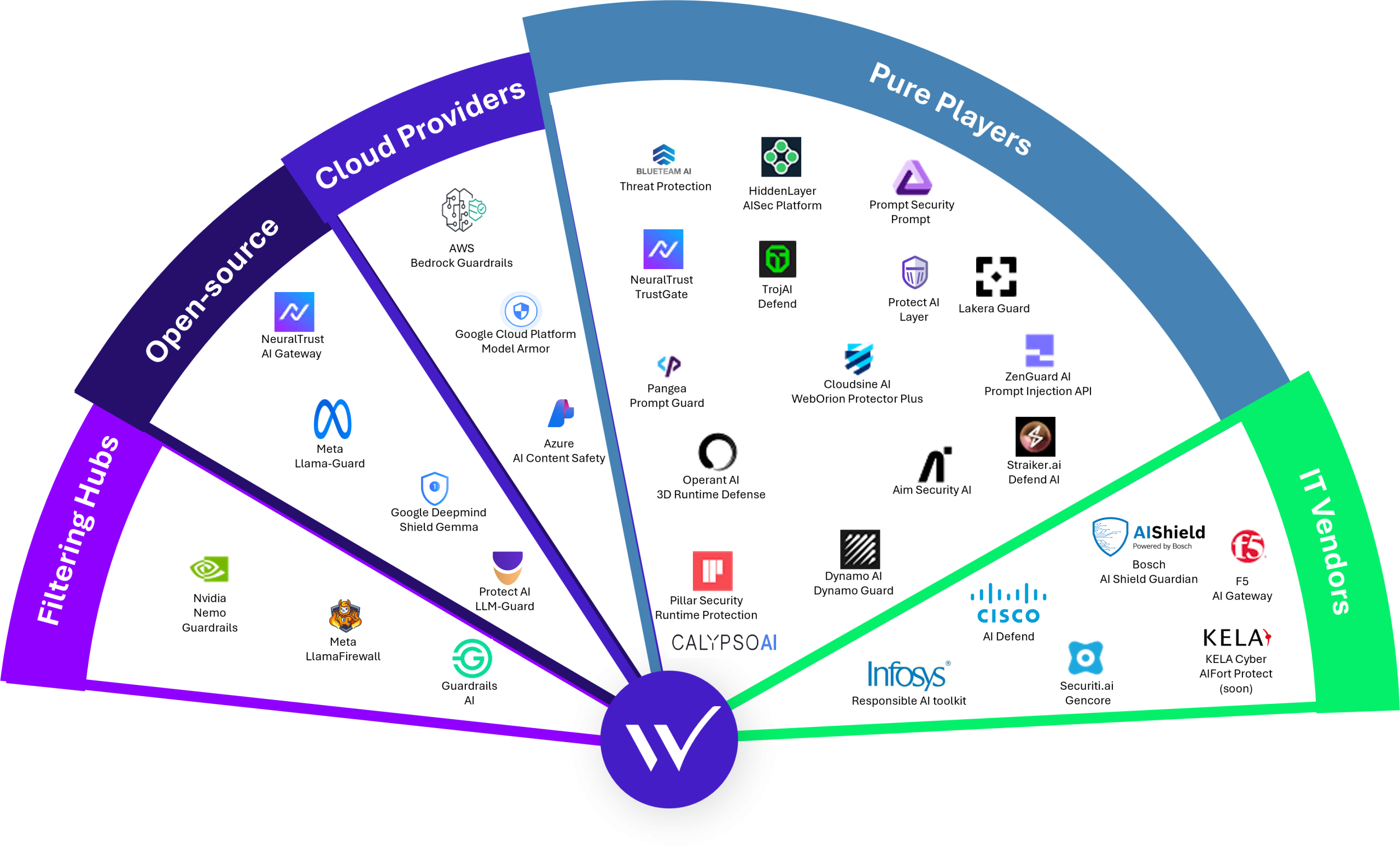

Une grande diversité de solutions

En 2025, le paysage de la sécurité IA et des guardrails LLM a connu une consolidation importante. Les principaux fournisseurs de cybersécurité ont cherché de plus en plus à élargir leurs offres avec des protections dédiées à l’IA générative, à l’utilisation des modèles et aux interactions avec les agents. Plutôt que de développer ces capacités à partir de zéro, beaucoup ont choisi d’acquérir des start-ups spécialisées afin d’intégrer rapidement des fonctionnalités de sécurité IA dans leurs plateformes existantes, comme SentinelOne avec Prompt Security ou CheckPoint avec Lakera.

Cette tendance illustre une évolution plus large du marché de la cybersécurité: les protections pour les applications basées sur le LLM deviennent une composante standard des offres de sécurité des entreprises, au même titre que les contrôles plus traditionnels. Les guardrails et les protections IA en temps réel ne sont plus des solutions de niche, mais sont progressivement intégrés dans les piles de sécurité classiques afin de soutenir l’adoption de l’IA à l’échelle des entreprises.

Critères de comparaison

Devant une telle diversité de solutions de filtrage IA, choisir la meilleure option devient un défi important. Les principaux critères devant être retenus sont :

- L’efficacité du filtrage, pour réduire l’exposition de l’application aux prompts malveillants tout en limitant les faux positifs.

- La latence, pour préserver l’expérience utilisateur.

- La capacité de personnalisation, pour adapter les filtres au contexte et aux risques spécifiques de l’application.

- Le coût opérationnel de la solution, pour s’assurer de la viabilité du passage à l’échelle dans le temps.

Résultats principaux et profils observés

Pour avoir une idée des performances des guardrails sur le marché, nous avons testé plusieurs solutions selon ces critères et plusieurs types de profils se sont démarqués :

- Certaines solutions offrent un déploiement rapide et une protection de base efficace avec une configuration minimale, ce qui les rend adaptées aux organisations qui cherchent à obtenir une première réduction rapide des risques. Ces solutions fonctionnent généralement bien dès leur installation, mais offrent des possibilités de personnalisation limitées.

- D’autres solutions mettent l’accent sur la flexibilité et le contrôle précis. Bien que ces frameworks permettent des stratégies de filtrage avancées, ils affichent souvent des performances par défaut médiocres et nécessitent un effort de configuration important pour atteindre de bons niveaux de protection.

Par conséquent, le choix d’une solution de guardrails dépend moins des scores de détection bruts que du niveau de personnalisation attendu, de la maturité opérationnelle et de l’effort de configuration acceptable.

Focus sur les guardrails proprosés par les Cloud Providers

Étant donné que la plupart des applications intégrant des LLMs sont déployées dans des environnements cloud, les guardrails natifs proposés par les fournisseurs cloud constituent une première couche de protection pragmatique. Ces solutions sont faciles à implémenter, rentables et s’intègrent facilement aux workflows cloud existants.

À l’aide d’outils automatiques spécialisés dans les tests de sécurité pour les applications d’IA (« AI Red Teaming »), nous avons observé que les filtres natifs proposés par les fournisseurs cloud bloquaient systématiquement la plupart des tentatives de prompt injection et de jailbreak. Et peu de différences de performances ont été observées, ce qui confirme leur pertinence en tant que mécanismes de protection de base pour les charges de travail de production.

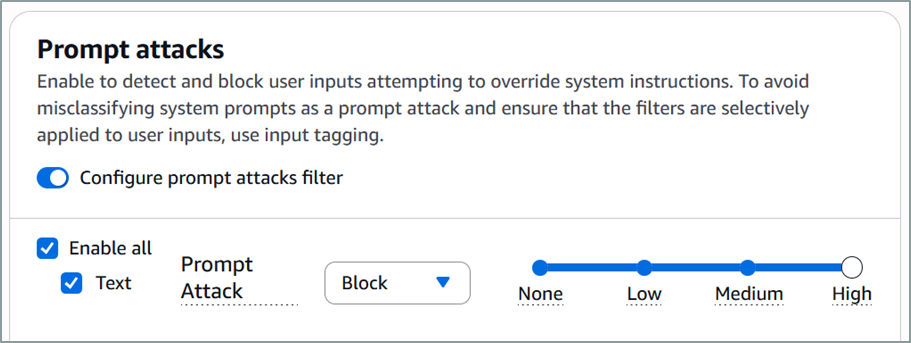

Configuration de la sensibilité de filtrage

La configuration de plusieurs solutions de fournisseurs de services cloud permettent de définir un niveau de sensibilité pour les guardrails configurés afin d’adapter la détection au niveau requis pour le cas d’usage considéré.

Nos tests montrent que même les configurations les plus permissives offrent une protection significative, tandis que les paramètres de sensibilité plus élevés, doivent être réservés aux cas d’usage critiques où la sécurité prime sur l’expérience utilisateur, puisque l’augmentation de la sensibilité de détection entraîne également davantage de faux positifs, où les messages légitimes des utilisateurs peuvent être bloqués. Le besoin d’arbitrage lié à cette première capacité de personnalisation des filtres illustre le besoin d’adapter chaque filtre au contexte de l’application.

Personnalisation

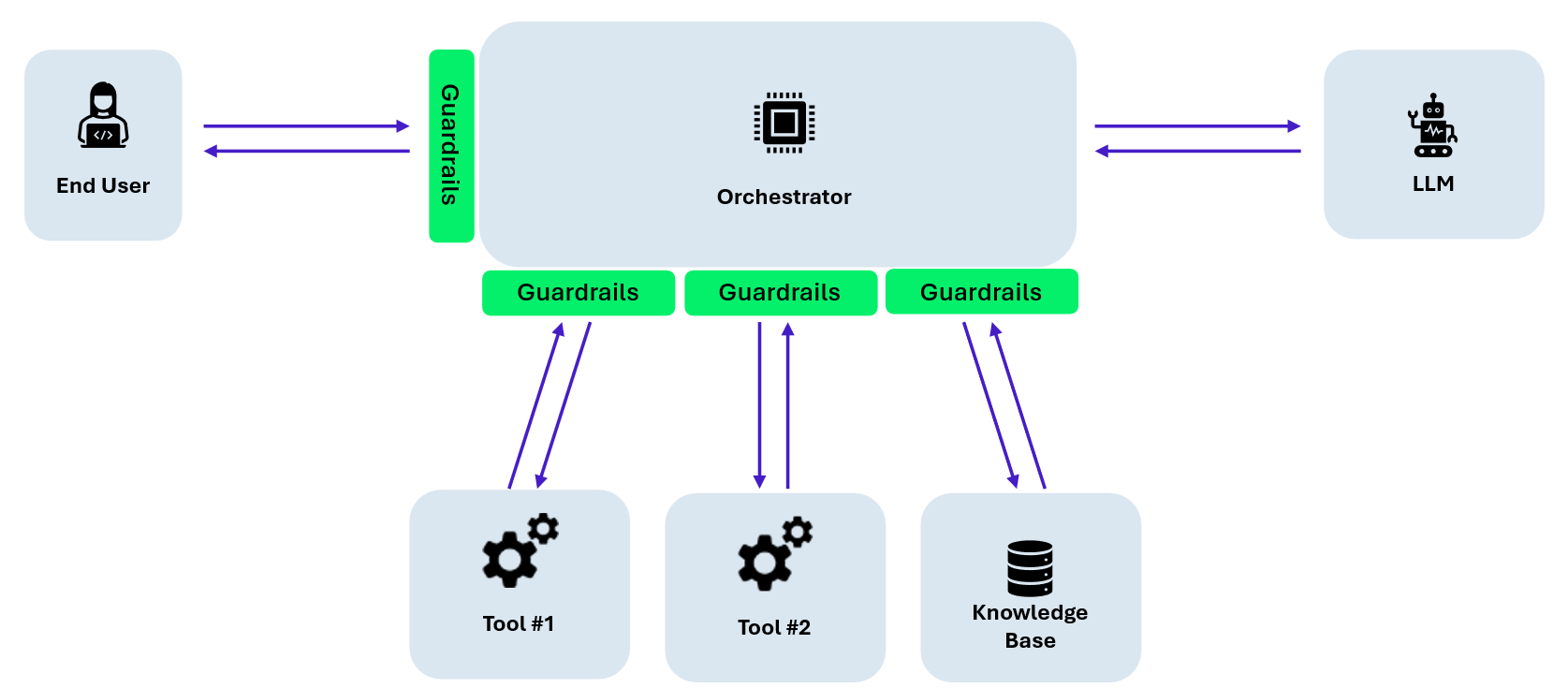

Au-delà du réglage de la sensibilité, une personnalisation fine est essentielle pour garantir l’efficacité des protections. Chaque application a des exigences spécifiques en matière de filtrage, qui dépendent du contexte de l’organisation, des contraintes réglementaires et de l’exposition aux menaces.

L’adaptation des filtres est requise à plusieurs niveaux:

- Le contexte de l’organisation: afin de bloquer des sujets spécifiques à l’application, tels que des entreprises concurrentes, des projets confidentiels ou des informations sensibles.

- La réduction des risques: pour permettre aux filtres de bloquer les attaques à fort impact telles que les prompt injections

- Les spécificités techniques de l’application, puisque chaque source de données et chaque outil demande une stratégie de filtrage différente. En effet, les entrées utilisateurs, extraits de documents récupérés (RAG) et résultats d’outils ne doivent pas être filtrés de la même manière.

L’application d’un filtrage uniforme à toutes les sources limite considérablement l’efficacité et peut créer des angles morts. Les garde-fous doivent donc être conçus comme faisant partie intégrante de l’architecture de l’application, et non comme un filtre monolithique unique.

Principaux constats

Notre étude met en évidence plusieurs points clés :

- Il n’existe pas de solution de guardrails unique adaptée à tous les cas d’usages, il faut trouver un compromis entre facilité de déploiement, performances et personnalisation.

- Les guardrails natifs du cloud constituent une base efficace et peu contraignante pour la plupart des applications hébergées dans le cloud.

- Les cas d’usages avancés nécessitent d’adapter la logique de filtrage au contexte de l’application et aux flux de données.

Les garde-fous doivent être sélectionnés en fonction de l’exposition au risque, de la maturité opérationnelle et de la maintenabilité à long terme, plutôt que sur la base des seuls scores de détection bruts.

Les guardrails sont devenus un élément indispensable des applications intégrant des LLM, et il existe désormais un large éventail de solutions. Pour choisir la plus adaptée à votre contexte, il faut identifier la solution qui correspond le mieux aux risques, aux contraintes et à l’architecture applicative spécifiques de votre application.

- Si votre application est déjà déployée dans un environnement cloud, l’utilisation des guardrails fournis par le fournisseur de cloud est une bonne solution.

- Si vous souhaitez plus de contrôle sur la solution de filtrage, le déploiement d’une des solutions open source peut être l’option la plus appropriée.

- Si vous voulez ce qu’il y a de mieux et que vous en avez les moyens, vous pouvez lancer un RFP ou RFI afin de comparer différentes solutions et sélectionner celle qui correspond le mieux à vos besoins.

Enfin, les garde-fous ne suffisent pas à eux seuls à protéger vos applications. La sécurité des applications LLM repose également sur des outils correctement configurés, des politiques IAM strictes et une architecture de sécurité robuste afin d’éviter des scénarios d’exploitation plus graves.