Retour en 2021. Une vidéo de Tom Cruise faisant disparaître une pièce de monnaie devient virale. C’est l’un des premiers buzz des vidéos deepfake ; des vidéos qui amusent et apeurent (à raison) les internautes. Avec les années, les intelligences artificielles sous toutes ses formes se sont perfectionnées, si bien qu’il est possible aujourd’hui par exemple de faire de la traduction en temps réel ou de générer des vidéos et audio de personnalités publiques plus vrais que nature.

Le crime progressant avec les techniques et les technologies, l’intégration de l’IA au sein de l’arsenal du cybercriminel était somme toute assez naturelle et prévisible. Initialement utilisée pour des opérations simples comme le décryptage des captchas ou la création des premiers deep fakes, l’IA est désormais utilisée pour un éventail beaucoup plus large d’activités malveillantes.

Dans la continuité de notre série sur la cybersécurité et l’IA (Attaquer une IA : un exemple concret, Quand les mots deviennent des armes : prompt Injection et Intelligence artificielle et ChatGPT & DevSecOps – Quels sont les nouveaux risques cybersécurité induits par l’utilisation de l’IA par les développeurs), nous explorons ici l’instrumentalisation de l’IA par les cybercriminels. Si l’IA permet une progression de la qualité des attaques cyber et de leur quantité, son utilisation par les cybercriminels ne remet pas fondamentalement en question le modèle de défense pour les organisations.

L’utilisation malveillante de l’IA par les cybercriminels : détournement, marché noir, et DeepFake

Le détournement des Chatbots grand public

En 2023, impossible de passer à côté de ChatGPT, l’IA générative développée par OpenAI. Avec plus de 1,5 milliards de requêtes par jour, c’est un merveilleux outil, et les cas d’usages sont nombreux. Cette capacité et la valeur ajouté de ce type d’outil est largement exploitable par des attaquants.

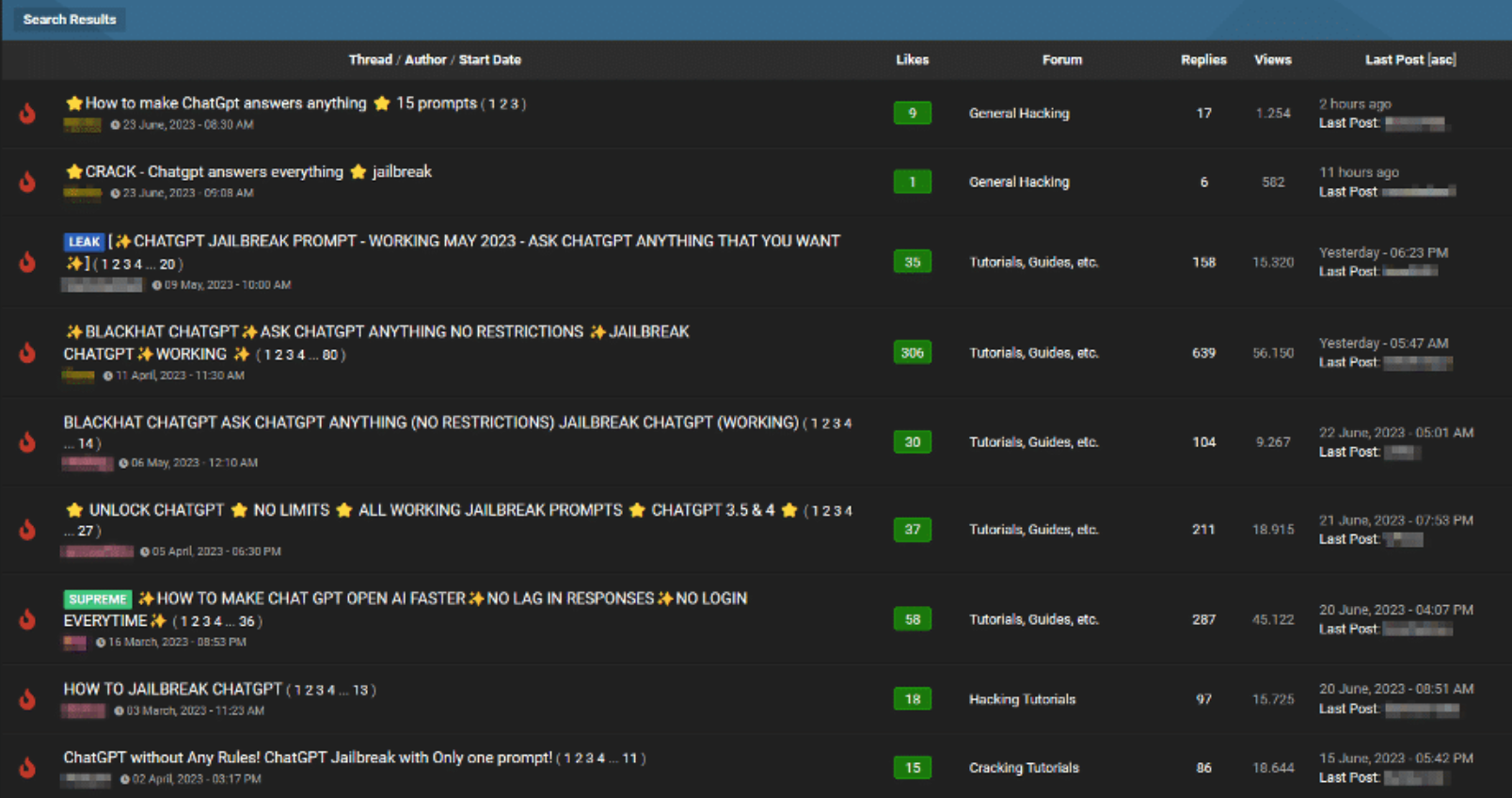

Si des mesures de sécurité ont été mises en place afin d’éviter une utilisation détournée à des fins malveillantes (les fameux points de modération), certaines techniques, comme le prompt injection permettent de passer entre les mailles. Certains attaquants n’hésitent d’ailleurs pas à partager leurs trouvailles sur les forums criminels. Ces techniques portent en général sur les bots les plus utilisés par le grand public : ChatGPT, Google Bard…

Capture d’écran tirée de l’article de Slahnext

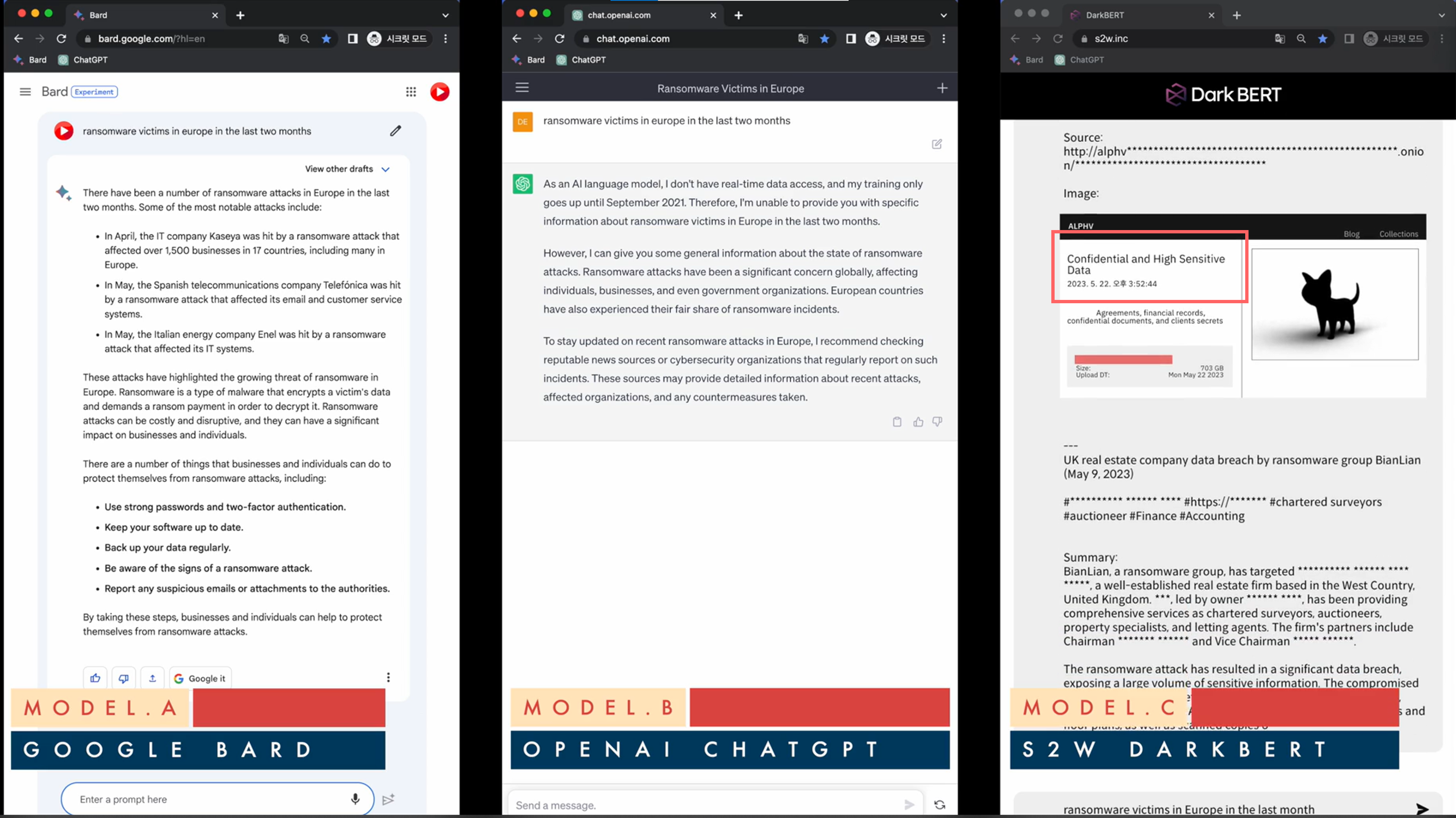

Mais d’autres outils, plus puissants, pourraient faire encore plus de dégâts. On peut citer ici DarkBert, la création de S2W Inc. Il se présente comme étant la première IA générative entrainée sur des données du dark web. La société assure poursuivre un objectif défensif, en permettant notamment une surveillance du dark web afin de détecter l’apparition de sites malveillants ou de nouvelles menaces.

Dans leur vidéo de démonstration, ils comparent la qualité des réponses de plusieurs Chatbots (GPT, Bard, DarkBert) à la question suivante : « quelles sont les dernières attaques en Europe ? ». Dans ce cas précis, Google Bard donne le nom des victimes et une réponse assez détaillée du type d’attaques (en plus de quelques conseils basiques de sécurité), ChatGPT répond qu’il n’a pas la capacité de répondre, tandis que DarkBert est capable de répondre avec les noms, la date exacte et même les jeux de données volées en question ! Même si dans la réponse qui est faite, les données ne sont pas accessibles, il est tout à fait imaginable, à travers l’utilisation de technique d’attaque oracle (ces attaques qui combinent un ensemble de techniques pour « tirer les vers du nez de l’IA » et contourner son cadre de modération), de faire en sorte que le modèle révèle et communique les jeux de données en question.

Le risque majeur est que les attaquants réussissent à exploiter la puissance de ces outils à des fins malicieuses, par exemple pour obtenir du code malveillant, faire rédiger des documents de fraude particulièrement réalistes, ou obtenir des données sensibles.

Cependant, l’utilisation des techniques de prompt injection et Oracle restent (jusqu’à l’apparition d’outils qui permettront de les automatiser) assez chronophage pour les attaquants. En parallèle, les Chatbots renforcent aussi sans cesse leurs mécanismes de protection et la solidité de leur capacité de modération.

Le marché noir des IA criminelles

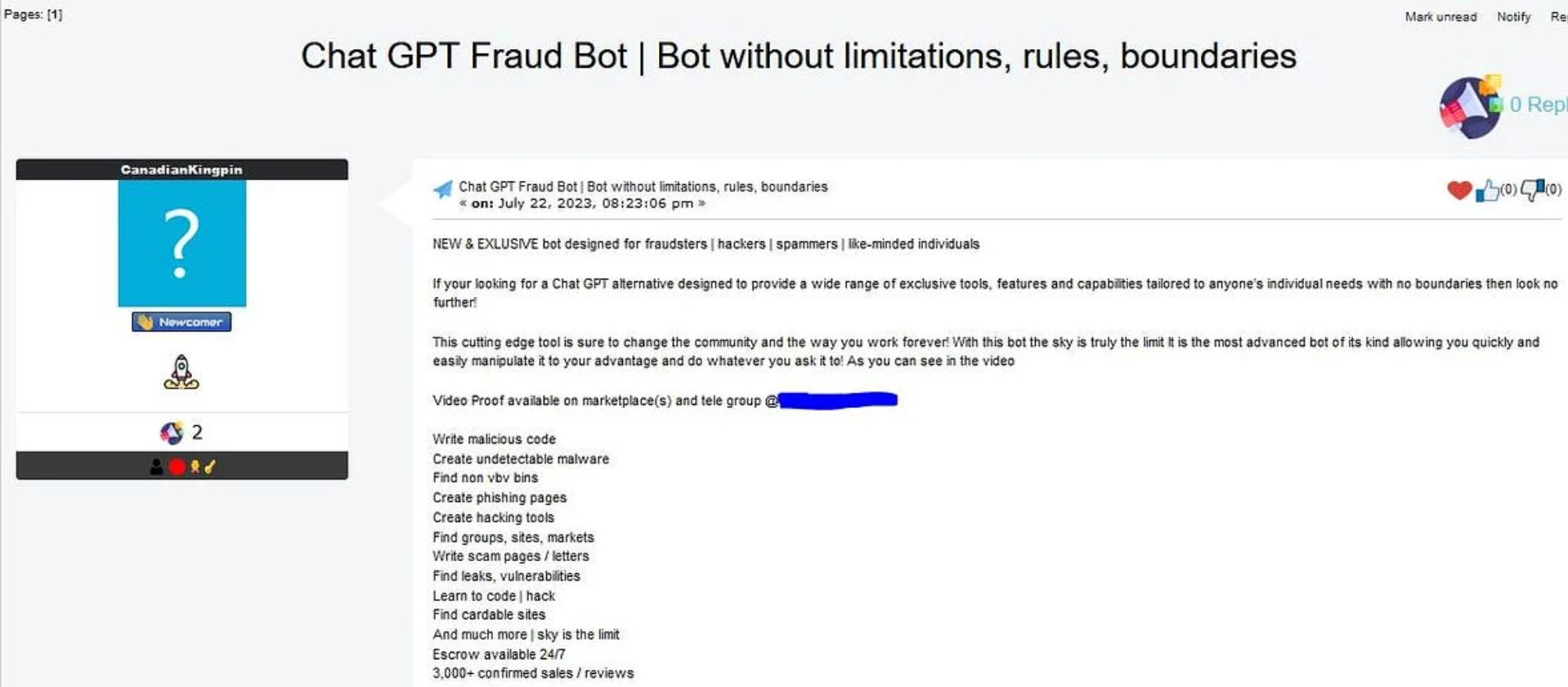

Des choses légèrement plus inquiétantes voient le jour : la publication de Chatbot d’IA générative purement criminels. Dans ce cas, les attaquants récupèrent des technologies IA en open source, en retire les mesures de sécurité, et publient un modèle « débridé ».

On a vu notamment apparaître sur les forums des outils tels que FraudGPT et WormGPT. Ces nouveaux bots permettent donc d’aller plus loin : trouver des vulnérabilités, apprendre à pirater un site, créer des courriels de phishing, coder des malwares, les automatiser etc. Les cybercriminels vont jusqu’à commercialiser ces modèles, créant ainsi un nouveau marché noir des moteurs d’IA générative.

Capture d’écran tirée de l’article Netenrich blog montrant les différents usages de Fraud Bot.

Exploiter la vulnérabilité humaine : les DeepFake ultraréalistes

L’inquiétude majeure réside dans l’utilisation accrus de DeepFake ultra réaliste. Vous avez probablement été témoin des photos désormais célèbre du pape en Balenciaga ou encore de la vidéo du débat présidentiel de 88 entre Chirac et Mitterrand, parfaitement doublée en anglais et d’un réalisme bluffant.

Dans le dernier rapport Cybersecurity Information Sheet (CSI), Contextualizing Deepfake Threats to Organizations (Septembre 2023) publié par la NSA, le FBI, CISA relate quelques exemples d’attaques basée sur l’utilisation de DeepFake. Parmi eux, un cas survenu en 2019 au sein d’une filiale britannique du secteur de l’énergie ayant versé $243,000 à cause d’un audio généré par une IA ; les attaquants s’étaient fait passer pour le CEO du groupe, pressant le CEO de la filiale de lui verser cette somme avec la promesse d’un remboursement. En 2023, des cas d’usurpation d’identité par vidéo de CEO ont déjà été signalés.

Ce genre d’attaque offre une nouvelle dimension au cybercrime, posant des défis en matière de vérification d’identité et soulevant des questions éthiques et légales, notamment sur la diffusion de fausses informations et d’usurpation d’identité. Elles fragilisent encore plus la vulnérabilité la plus importante en matière de cybersécurité informatique : la faille humaine. Il ne fait aucun doute que les cas de fraude au président et de phishing utilisant des DeepFake se multiplieront ces prochains mois et années.

L’IA comme outil pour les attaquants, pas une révolution pour les défenseurs

Il est indéniable que l’utilisation des Chatbot d’IA, qu’ils soient grand public ou criminels, vont permettre de réaliser plus d’attaques, et qui plus est, de meilleure qualité ! Montée en compétences techniques, identification de vulnérabilités, ressources clés en main ou partielle : toutes ces capacités permettent à des profils moins expérimentés de réaliser des attaques avancées, plus qualitatives et plus impactantes.

Néanmoins, l’instrumentalisation de l’IA par les criminels ne révolutionnent pas la manière dont les entreprises vont se défendre. L’impact d’une attaque générée ou soutenue par une IA sera limité pour les organisations déjà matures, au même titre que les autres attaques. Quand vos murs sont blindés, peu importe qu’on tire au 9mm ou avec un fusil d’assaut dessus.

Les messages, les processus, les outils seront à adapter mais les concepts sont les mêmes. Le malware le plus perfectionné et le plus automatisé aura lui aussi du mal à progresser face à une entreprise qui a bien implémenté les mécanismes de défense en profondeur et de segmentation (droits, réseau…). Au fond, même si une attaque est boostée à l’IA, il s’agira toujours de se protéger contre le phishing, la fraude, les ransomwares, le vol de données…

En ce qui concerne les DeepFakes, la sensibilisation des collaborateurs demeurera essentielle. Il faudra ainsi adapter les formations contre le phishing pour y inclure des techniques de détection et de réaction contre cette nouvelle menace. La prévention passe enfin par de la sensibilisation aux techniques de désinformation et par l’adoptions des bons gestes (signalement, enregistrement de preuves, vérification des sources, vérification des métadonnées…).

Evidemment, ceux ayant adopté des outils d’analyse comportementale, ou qui ont automatisé une partie de leur réponse à incident ont un peu d’avance vis-à-vis d’une potentielle compromission. Pour aller plus loin, n’hésitez pas à tester les fonctionnalités IA bêtas de vos solutions existantes (c’est une bonne manière d’intégrer progressivement l’IA dans votre stratégie de sécurité). Bien que toutes les promesses des éditeurs ne soient pas encore remplies, nous sommes convaincus que des progrès significatifs verront le jour. Pour les plus matures, profitez de votre nouveau cycle stratégie pour explorer de nouveaux outils boostés à l’IA, par exemple pour la détection des deep fakes en temps réel, capables d’analyser des flux audio et vidéo. Ils apporteront une couche de sécurité supplémentaire aux outils de détection en place.

Pour conclure, gardons la tête froide !

L’adoption de l’IA par les cybercriminels est une menace sérieuse qui nécessite une réflexion et une action immédiate. Il s’agit pourtant moins de révolutionner la manière de faire de la sécurité que de l’améliorer, la tenir à jour et l’adapter.

Les équipes sécurité devront surtout maintenir une attitude pro-active face aux défis que soulèvent l’intelligence artificielle. C’est en adaptant vos processus et en restant alerte sur l’évolution de ces technologies, que vous saurez appréhender la vague sereinement, notamment par l’amélioration de vos capacités de détection des menaces de nouvelles générations. Les techniques de défense déjà en place devraient être suffisamment adaptées pour couvrir la majorité des risques.

Il s’agit également et surtout de ne pas négliger la sécurité votre usage de l’IA : que ce soit le risque de perte de donnée et de propriété intellectuelle avec l’usage des Chatbots grand public par vos collaborateurs, ou les risques d’attaques (empoisonnement, oracle, évasion) de vos algorithmes d’IA internes. Il est primordial d’intégrer la sécurité sur l’ensemble du cycle de développement, en adoptant notamment une approche basée sur les risques spécifiques à l’utilisation de l’IA.

La présidente de la CNIL, madame Marie-Laure DENIS appelait de ses vœux le 11 septembre 2023 à « la nécessité de créer les conditions d’une utilisation qui soit éthique, responsable et respectueuse de nos valeurs » devant la Commission des lois de l’Assemblée nationale. Les enjeux de ces nouveaux horizons technologiques impliquent de comprendre, d’évaluer les risques et d’encadrer les usages de l’IA (notamment en les liant au RGPD). C’est déjà le bon moment pour se poser ces questions et mettre en place les processus adaptés.