Dans un cadre réglementaire dynamique autour de l’Intelligence Artificielle, les efforts récents en matière de gouvernance et de réglementation de l’Intelligence Artificielle ont évolué d’une série de mesures dispersées et réactives vers des cadres politiques cohérents. L’ambition de ces cadres sont doubles : encourager l’innovation tout en limitant les utilisations abusives de l’IA.

Alors que l’Intelligence Artificielle est de plus en plus présente dans notre quotidien, des inquiétudes concernant l’éthique de cette technologie se font entendre de la part du secteur public ainsi que du secteur privé à propos de la vie privée, les biais, la responsabilité et la transparence.

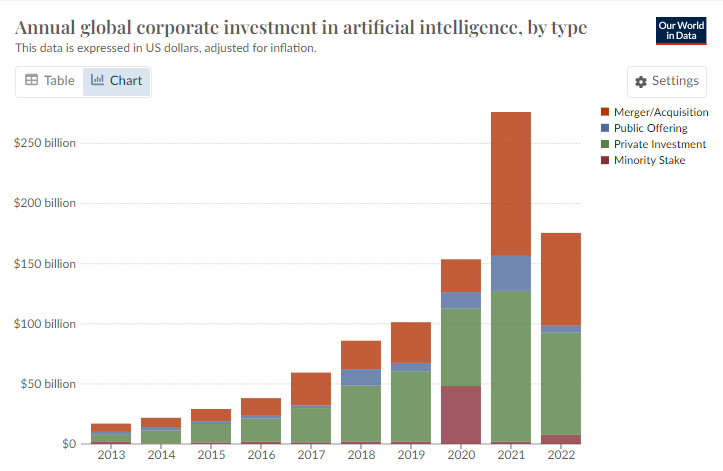

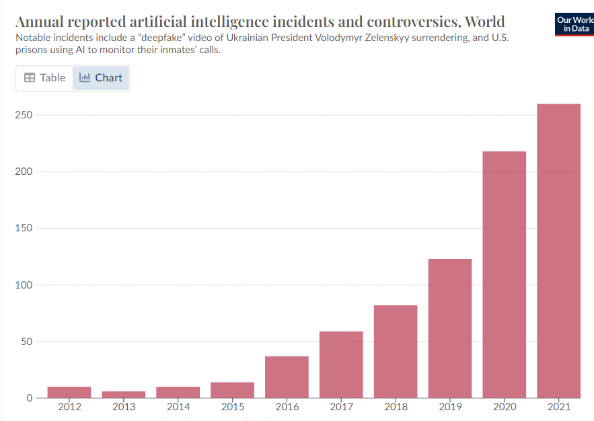

Source: https://ourworldindata.org/artificial-intelligence

Aujourd’hui, alors que les gouvernements rédigent activement des orientations et des législations sur l’IA, les responsables politiques font face au défi de trouver un équilibre entre encourager l’innovation et garantir la responsabilité. Un cadre réglementaire qui privilégie l’innovation mais s’appuie trop fortement sur l’autorégulation du secteur privé pourrait conduire à un manque de surveillance et de responsabilité. En revanche, tandis que des garde-fous robustes sont essentiels pour atténuer les risques, une approche trop restrictive pourrait ralentir le progrès technologique.

Cet article explorera les approches proposées par les gouvernements des États-Unis et du Royaume-Uni en ce qui concerne la gouvernance de l’IA dans les secteurs public et privé.

L’approche américaine envers la régulation de l’IA

En octobre 2023, la Maison Blanche a publié l’“AI Executive Order”. L’ordonnance spécifie les principales priorités à court terme. Elle introduit l’obligation de produire des rapports pour les développeurs d’IA dépassant une certaine puissance de calculs, le lancement d’initiatives de recherche, le développement de projets pour une utilisation responsable de l’IA et l’établissement d’une gouvernance de l’IA au sein du gouvernement fédéral. Les efforts à plus long terme se concentrent sur la coopération internationale, les normes mondiales et la sécurité de l’IA.

Concernant la garantie de responsabilité, l’ordonnance demande au Secrétaire au Commerce d’appliquer les dispositions de déclaration aux :

- Entreprises qui développent des modèles fondamentaux d’IA à double usage

- Organisations qui achètent des clusters informatiques à grande échelle

- Fournisseurs d’infrastructures IaaS qui permettent à des entités étrangères de mener certains entraînements de modèles d’IA.

Bien que ces critères excluent probablement la plupart des petites et moyennes entreprises de ces directives, les acteurs majeurs du domaine comme Open AI, Anthropic et Meta pourraient être affectés s’ils dépassent le seuil de calcul établi par l’ordonnance.

En parallèle, d’autres sections de l’ordonnance réaffirment l’objectif du gouvernement américain de promouvoir l’innovation et la concurrence en matière d’IA en soutenant les initiatives de R&D et les partenariats public-privé, en simplifiant les processus de visa pour attirer les talents en IA aux États-Unis, en priorisant le recrutement axé sur l’IA au sein du gouvernement fédéral et en clarifiant les problèmes de propriété intellectuelle liés à l’IA.

Dans l’ensemble, la nature des documents publiés par les États-Unis est principalement non contraignante. Cela semble indiquer une stratégie visant à encourager le secteur privé à s’autoréguler et à s’aligner sur les meilleures pratiques courantes en matière d’IA. La Maison Blanche a été constante dans son message selon lequel elle s’engage à encourager l’innovation, la recherche et le leadership dans ce domaine, tout en contrebalançant avec la nécessité d’un écosystème d’IA sécurisé et responsable.

L’approche britannique envers la régulation de l’IA

La Déclaration de Bletchley, adoptée lors du Sommet sur la Sécurité de l’IA 2023 tenu à Bletchley Park, dans le Buckinghamshire, marque un effort international pionnier visant à assurer le développement sûr et responsable des technologies d’IA. Cette déclaration représente l’engagement de 29 gouvernements dont le Royaume-Uni, les Etats-Unis, la Chine et les principaux États membres européens, à collaborer pour développer une IA centrée sur l’humain, digne de confiance et responsable. L’accent est mis sur l’IA de pointe, qui désigne des modèles d’IA très puissants et généralistes qui pourraient présenter des risques majeurs, notamment dans des domaines tels que la cybersécurité et la biotechnologie.

La déclaration souligne la nécessité pour les gouvernements de prendre des mesures proactives pour garantir le développement sûr de l’IA, reconnaissant le déploiement omniprésent de la technologie dans la vie quotidienne, y compris le logement, l’emploi, l’éducation et les soins de santé. Elle appelle au développement de politiques basées sur les risques, de métriques d’évaluation appropriées, d’outils pour les tests de sécurité, ainsi qu’à la construction de capacités pertinentes dans le secteur public et la recherche scientifique.

En prime de la déclaration, un document politique sur les « Tests de sécurité” de l’IA a également été signé par dix pays, dont le Royaume-Uni et les États-Unis, ainsi que par des grandes entreprises technologiques. Ce document donne un cadre général pour le test des modèles d’IA de nouvelle génération par les agences gouvernementales, promeut la coopération internationale et permet aux agences gouvernementales de développer leurs propres approches en matière de réglementation de la sécurité de l’IA.

Les principaux enseignements de la Déclaration de Bletchley envoient un signal clair des gouvernements concernant l’urgence de s’intéresser au développement d’une IA sûre. Cependant, la manière dont ces engagements se traduiront par des propositions législatives spécifiques et le rôle de l' »AI Safety Institute “(AISI) récemment annoncé dans le paysage réglementaire du Royaume-Uni restent à voir. La mission de l’AISI est de limiter les surprises liées aux avancées rapides et inattendues de l’IA en se concentrant sur le test et l’évaluation des systèmes d’IA avancés, la recherche fondamentale sur la sécurité de l’IA et l’encouragement des échanges d’informations.

Alors qu’ils cherchent à s’établir en tant que leaders de l’IA dans la communauté mondiale pour tendre vers des IA de confiance, tant les États-Unis que le Royaume-Uni cherchent l’équilibre entre la promotion de l’innovation en matière d’IA et la garantie d’une gouvernance éthique. Bien que la plupart des efforts actuels se focalisent sur la proposition de lignes directrices et de cadres pour l’utilisation sûre et responsable de l’IA, la mention de réglementations futures potentielles dans les deux documents devrait servir d’incitations pour que les entreprises commencent à aligner leurs pratiques sur les principes et les recommandations énoncés.

Pour garder leur avance, les organisations devront développer des méthodologies strictes pour surveiller efficacement les risques liés à l’IA. Cela signifie qu’il faudra adapter leur stratégie d’IA pour prioriser la limitation des risques, identifier les dommages potentiels qui peuvent découler du déploiement de systèmes d’IA et se préparer aux mesures réglementaires futures en mettant en œuvre un programme de gestion des risques sécurisé et complet.

Cependant, l’approche opportuniste des États-Unis et du Royaume-Uni en matière de législation sur l’IA n’est pas suivie par tous. La Chine a opté pour une approche ciblée et évolutive en rédigeant une loi sur l’IA générative qui est entrée en vigueur en 2023. En Europe, l’AI Act montre que l’UE ne veut pas perdre le contrôle face à l’IA.