Depuis les prémices de sa théorisation dans les années 1950 lors de la conférence de Dartmouth[1], l’Intelligence Artificielle (IA) a connu un développement important. Aujourd’hui, grâce à certains facteurs comme les progrès techniques dans divers domaines technologiques tels que le cloud computing par exemple, nous la retrouvons dans des usages quotidiens variés. L’IA compose des chansons, reconnait nos voix, anticipe nos besoins, conduit notre voiture et surveille notre santé…

Naturellement, le développement de l’IA fait naître de nombreuses craintes de la part des citoyens. Parmi les plus communes, nous retrouvons, par exemple, que l’IA fasse de mauvais choix conduisant à des incidents (voitures autonomes), ou encore qu’elle entraine une violation des données personnelles qu’elle manipule potentiellement (crainte largement alimentée par les scandales éclatant autour de grands acteurs du marché[2]).

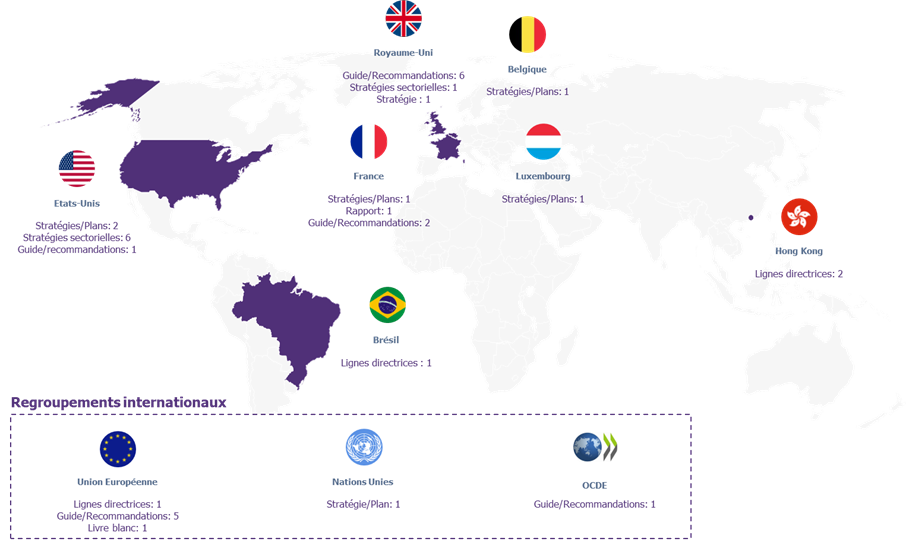

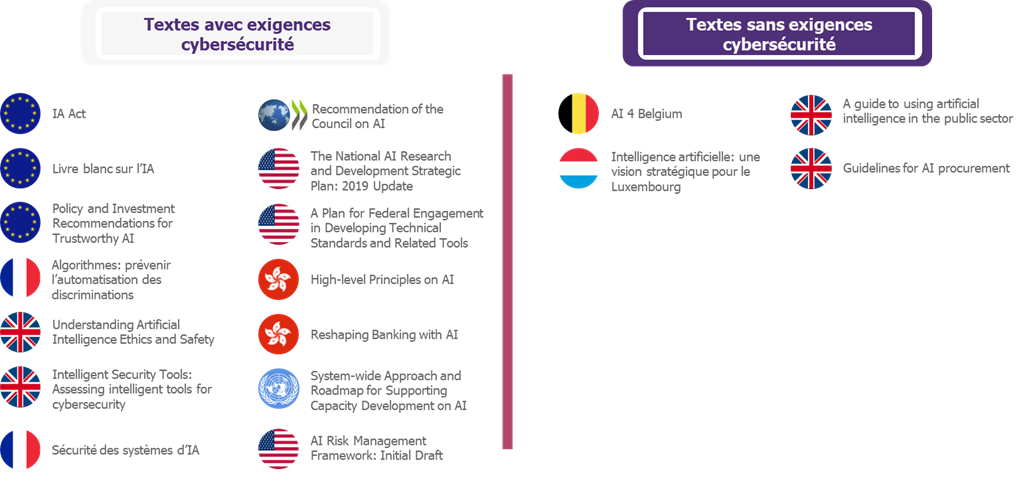

En l’absence de règlementations claires en matière d’IA, Wavestone a souhaité étudier, notamment à des fins d’anticipation des besoins à venir, qui sont les acteurs sur le devant de la scène en matière de textes sur l’encadrement de l’IA, quels sont ces textes, les idées qui y sont développées et quels impacts sur la sécurité de systèmes d’IA sont à anticiper.

Réglementation en matière d’IA : le panorama mondial

Législation en matière d’IA

Dans l’ensemble des textes relatifs à la règlementation en matière d’IA, il n’existe pas, à date, de textes législatifs[3][4] à proprement parler. Néanmoins, les textes formalisent généralement un ensemble de grandes lignes directrices pour développer un cadre normatif de l’IA. Il y a, par exemple, des guides/recommandations, des plans stratégiques ou encore des livres blancs.

Ils émergent principalement des Etats-Unis, de l’Europe, de l’Asie ou de grandes instances internationales :

Figure 1: Panorama mondial des textes sur l’IA[5]

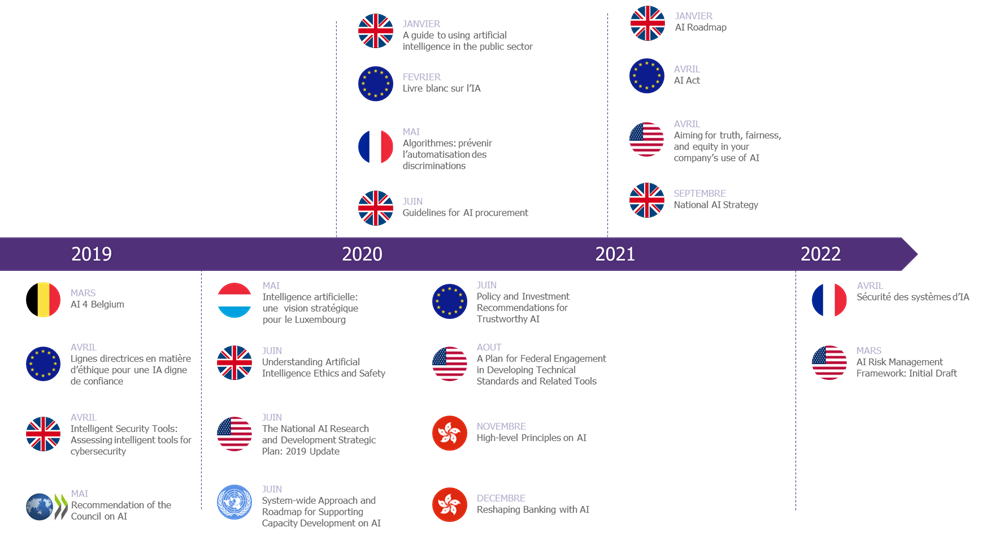

Et leur cadence ne faiblit pas ces dernières années. Depuis 2019, de plus en plus de textes en matière de règlementation de l’IA sont produits :

Figure 2 : Chronologie des principaux textes

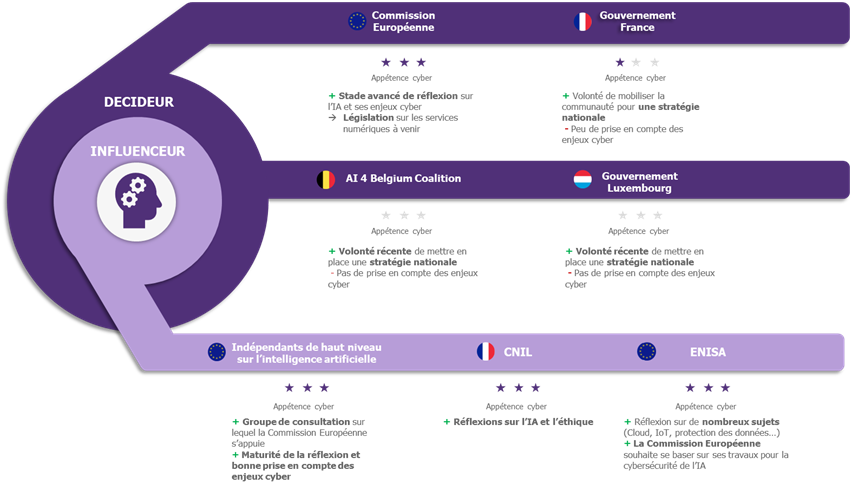

Deux types d’acteurs portent ces textes avec des connaissances parfois hétérogènes en matière de cybersécurité

Les textes sont généralement portés par deux types d’acteurs :

- Des décideurs. C’est-à-dire des instances dont l’objectif est de formaliser les règlementations et les exigences auxquelles les systèmes d’IA devront répondre.

- Des influenceurs. C’est-à-dire des instances/organisations qui possèdent une certaine autorité dans le domaine de l’IA.

A l’échelle de l’Union Européenne, des décideurs comme la Commission Européenne ou des influenceurs comme l’ENISA ont une importance capitale dans le développement des règlementations ou bonnes pratiques en matière de développement d’IA.

Figue 3 : Principaux acteurs en Europe

De manière générale, les textes adressent un nombre de thématiques variées. Ils donnent par exemple des stratégies à adopter ou des lignes directrices en matière d’éthique d’IA. Ils s’adressent tant aux gouvernements qu’aux entreprises et visent parfois des secteurs particuliers comme le secteur bancaire.

D’un point de vue cybersécurité, les textes sont hétérogènes. Le graphique suivant représente l’appétence cyber des textes :

Figure 4 : Corpus de textes entre 2018 et 2021

Ce que disent les textes en matière de Cybersécurité

Comme le montre la Figure 4, un nombre important de textes proposent des exigences liées à la cybersécurité. Cela s’explique en partie car l’IA a des spécificités fonctionnelles qui doivent être adressées par des exigences cyber particulières. Pour entrer dans le détail technique des textes, réduisons l’IA à une de ses techniques les plus utilisées à date : le Machine Learning (Les détails du fonctionnement du Machine Learning sont fournis en Annexe I : Machine Learning).

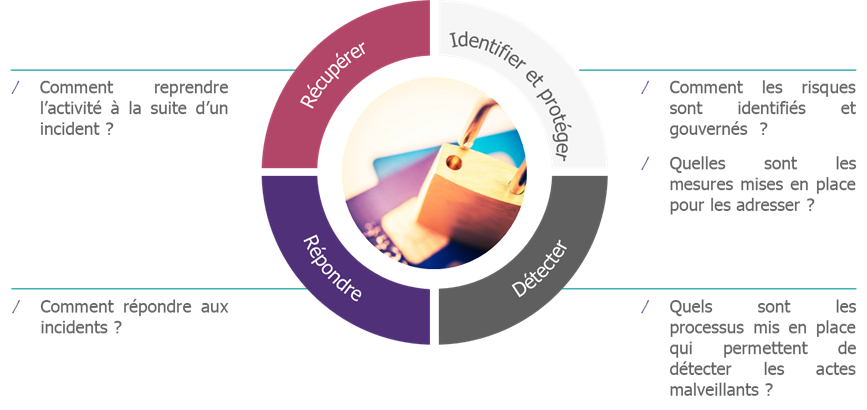

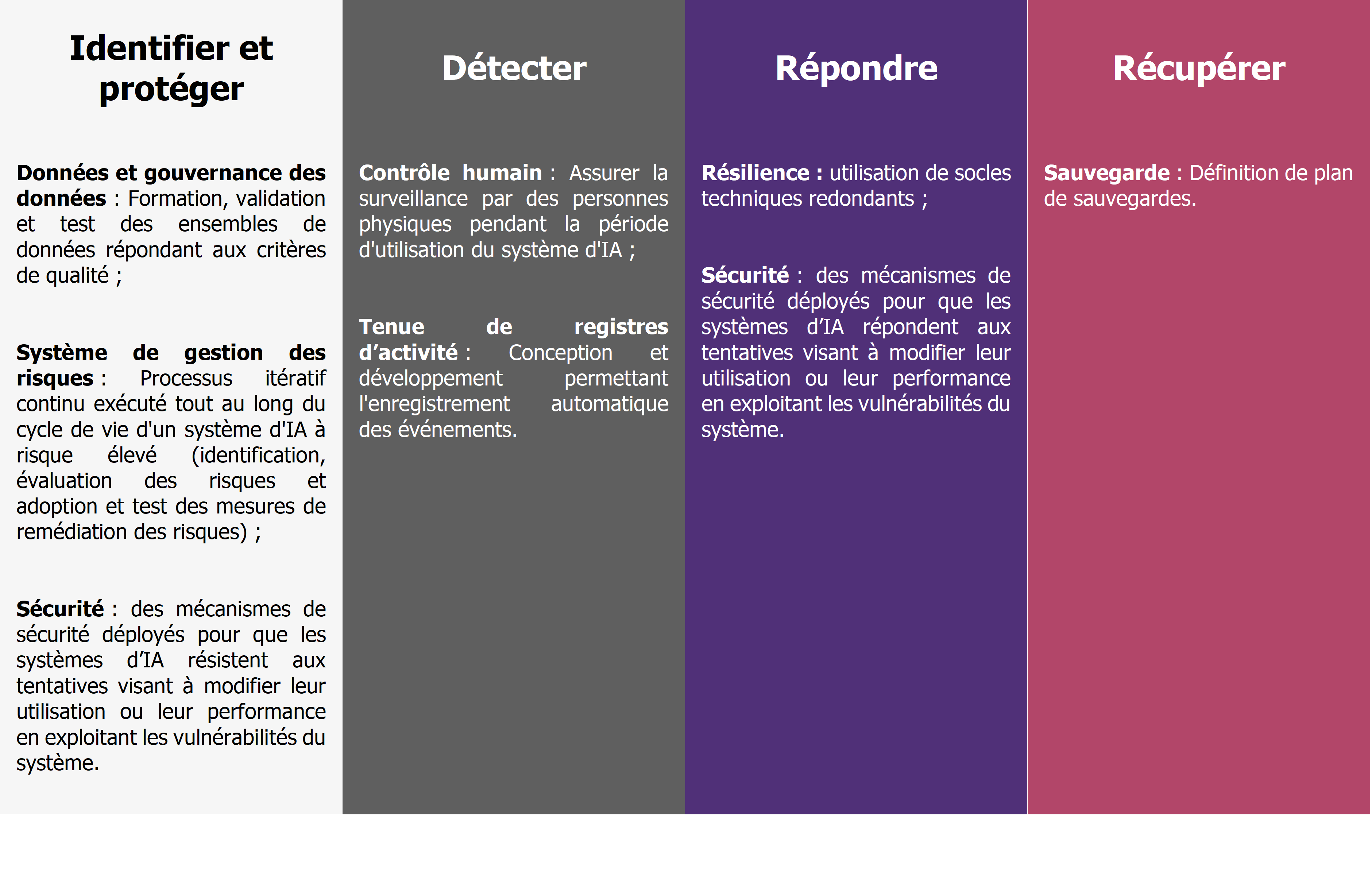

De nombreuses exigences cyber existent pour protéger les actifs supports des applications utilisant du ML Machine Learning (ML) tout au long du cycle de vie des projets. A l’échelle macroscopique, ces exigences peuvent être catégorisées dans les piliers classiques de la cybersécurité[6] extraits du Framework NIST[7] :

Figure 5 : Piliers de la cybersécurité

Le schéma suivant représente ainsi différents textes avec les volets cyber qu’ils comportent :

Figure 6 : Spécificités cyber de quelques textes importants

De façon générale, si nous croisons les résultats de la Figure 6 avec ceux de l’étude de l’ensemble des textes, il vient que trois exigences sont particulièrement adressées :

- Analyser les risques sur les systèmes de ML en prenant en compte leurs spécificités, pour identifier à la fois les mesures de sécurité « classiques » et celles spécifiques aux systèmes de ML. Pour cela, il convient généralement de respecter les étapes suivantes :

- Comprendre les intérêts des attaquants à attaquer le système de ML.

- Identifier la sensibilité des données manipulées dans le cycle de vie du système de ML (Par exemple : personnelles, médicales, militaires etc.).

- Cadrer les besoins juridiques et de droits de propriété intellectuelle (à qui appartient le modèle et les données manipulées dans le cas d’un hébergement dans le cloud par exemple).

- Comprendre où sont hébergées les différents actifs supports des applications utilisant le Machine Learning tout le long du cycle de vie du système de Machine Learning. Par exemple, certaines applications peuvent être hébergées en cloud, d’autres on-premise. Il convient d’ajuster sa stratégie des risques cyber en conséquence (Gestion des prestataires, des différents flux etc.).

- Comprendre l’architecture et l’exposition du modèle. Certains modèles sont plus exposés que d’autres aux attaques spécifiques aux Machine Learning. Par exemple certains modèles sont exposés publiquement et peuvent ainsi faire l’objet d’une phase de reconnaissance approfondie de la part d’un attaquant (par exemple en glissant des inputs et en observant les outputs).

- Inclure les attaques spécifiques sur les algorithmes de Machine Learning. Il en existe trois majeures : les attaques de type évasion (qui vise l’intégrité), de type oracle (qui vise la confidentialité) ou celle de type empoisonnement (qui vise l’intégrité et la disponibilité).

- Tracer et surveiller les actions. Cela comprend au moins deux niveaux :

- La traçabilité (log des actions) pour permettre une surveillance des accès aux ressources exploitées par le système ML.

- Des règles de détection plus « métiers » pour vérifier que le système est toujours performant et éventuellement détecter si une attaque est en cours sur celui-ci.

- Avoir une gouvernance de la donnée. Comme expliqué en Annexe I : Machine Learning, Les données sont la matière première des systèmes de ML. Ils convient donc de prendre un ensemble de mesures pour la protéger comme :

- S’assurer de l’intégrité lors de l’intégralité du cycle de vie de la donnée.

- Sécuriser l’accès à la donnée.

- S’assurer de la qualité de la donnée récoltée.

Il y a fort à parier que ces points seront présents dès les premières règlementations publiées.

L’AI Act : l’Europe prendra-t-elle les devants comme pour le RGPD ?

Dans le cadre de cette étude, nous avons approfondi ce qui avait été fait au sein de l’Union Européenne et un texte a particulièrement attiré notre attention.

L’affirmation selon laquelle il n’existe pas encore de texte législatif est en partie vraie. En effet, en 2021, la commission européenne a publié l’AI Act[8] : une proposition législative qui vise à tenir compte des risques associés à certaines utilisations de l’IA. Ses objectifs, pour citer le document, sont de :

- Veiller à ce que les systèmes d’IA mis sur le marché de l’Union et utilisés soient sûrs et respectent la législation en vigueur en matière de droits fondamentaux et les valeurs de l’Union ;

- Garantir la sécurité juridique pour faciliter les investissements et l’innovation dans le domaine de l’IA ;

- Renforcer la gouvernance et l’application effective de la législation existante en matière de droits fondamentaux et des exigences de sécurité applicables aux systèmes d’IA ;

- Faciliter le développement d’un marché unique pour des applications d’IA légales, sûres et dignes de confiance, et empêcher la fragmentation du marché.

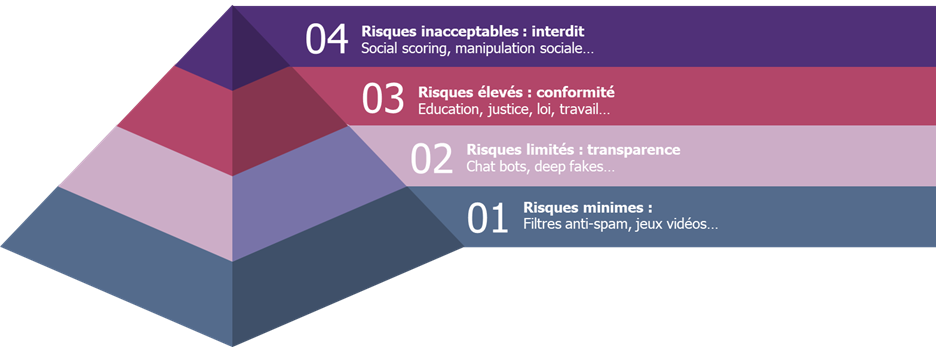

L’AI Act s’inscrit dans la logique des textes énumérés ci-dessus. Il adopte une approche basée sur le risque avec des exigences qui dépendent des niveaux de risque des systèmes d’IA. Le règlement définit ainsi quatre niveaux de risque :

- Les systèmes d’IA à risques inacceptables ;

- Les systèmes d’IA à haut risque ;

- Les systèmes d’IA présentant des risques spécifiques ;

- Les systèmes d’IA présentant des risques minimes.

Chacun de ces niveaux fait l’objet d’un article dans la proposition législative afin de les définir précisément et de construire la réglementation associée.

Figure 7 : La hiérarchie des risques présente dans l’AI Act[9]

Pour les systèmes d’IA à risques élevés, l’AI Act propose des exigences cyber dans la lignée de celles présentées plus haut. Par exemple, si nous reprenons la catégorisation inspirée du NIST présentée dans la Figure 5 :

Même si le texte n’est qu’une proposition (elle peut être adoptée d’ici 1 à 5 ans), nous remarquons que L’Union Européenne, comme avec les données à caractère personnel et le RGPD, prend les devants en proposant un règlement audacieux pour accompagner le développement de l’IA.

Quels avenirs pour la règlementation en matière d’IA et la cybersécurité ?

Ces dernières années de nombreux textes en matière de règlementation des systèmes d’IA ont été publiés. Bien qu’il n’existe pas, à date, de textes législatifs, on remarque tout de même que la pression s’intensifie avec de nombreux textes comme en témoigne par exemple l’AI Act, une proposition de l’Union Européenne. Ces propositions fournissent des exigences en matière de stratégie de développement d’IA, d’éthique et de cybersécurité. Pour cette dernière, les exigences touchent surtout des sujets comme la gestion des risques cyber, le monitoring, la gouvernance et la protection des données. De plus, il y a fort à parier que les premières règlementations proposeront une approche basée sur les risques avec des exigences adaptées en fonction des niveaux de risques.

Par rapport à son analyse de la situation, Wavestone ne peut qu’encourager à développer une approche comme celle proposée par l’AI Act en adoptant une méthodologie basée sur les risques. C’est-à-dire à identifier les risques portés par les projets et à implémenter des mesures de sécurité adaptées. Cela permettrait d’ores et déjà de se mettre en ordre de marche et d’éviter une mise en conformité à posteriori.

Annexe I : Machine Learning

Le Machine Learning (ML) se définit comme l’opportunité laissée aux systèmes[10] d’apprendre à résoudre une tâche à l’aide de données sans y être explicitement programmés. De manière heuristique, un système de ML apprend à donner une « sortie adéquat », par exemple est-ce que telle image issue d’un scanner présente une tumeur, à partir de données d’entrées (i-e l’image d’un scanner dans notre exemple).

Pour citer l’ENISA[11], les spécificités sur lesquelles repose le Machine Learning sont les suivantes :

- La donnée. Elle est au cœur du Machine Learning. La donnée est la matière première consommée par les systèmes de ML pour apprendre à résoudre une tâche puis pour la réaliser une fois en production.

- Un modèle. C’est-à-dire un modèle mathématique et algorithmique qui peut se voir comme une boîte avec un grand ensemble de paramètres ajustables utilisés pour donner une sortie à partir de données d’entrée. Lors d’une phase appelée l’apprentissage, le modèle utilise des données pour apprendre à résoudre une tâche en ajustant automatiquement ses paramètres, puis une fois mise en production il pourra mener la tâche à bien grâce aux paramètres ajustés.

- Des process spécifiques. Ces process spécifiques adressent l’ensemble du cycle de vie du système de ML. Ils portent par exemple sur la donnée (traitement de la donnée pour la rendre exploitable par exemple) ou sur le paramétrage du modèle lui-même (comment le modèle ajuste ses paramètres à partir des données qu’il utilise).

- Des outils et environnements de développement. Par exemple, beaucoup de modèles sont entraînés puis stockés directement sur des plateformes cloud car ils nécessitent beaucoup de ressources pour effectuer les calculs du modèle.

- Des acteurs. Notamment car de nouveaux métiers ont été créés avec l’essor du Machine Learning comme les fameux Data Scientists.

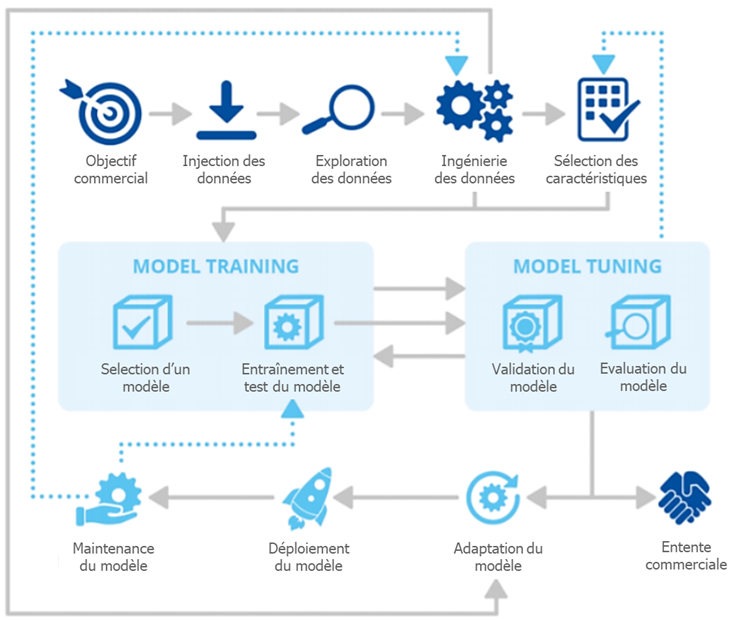

Généralement, le cycle de vie d’un projet de Machine Learning peut se décomposer selon les étapes suivantes :

Figure 8 : cycle de vie d’un projet de Machine Learning[12]

Annexe 2 Liste non exhaustive de textes relatifs à l’IA et à l’encadrement de son développement

|

Pays ou regroupement international |

Titre du document |

Publié par |

Date de publication |

|

France |

Donner un sens à l’IA: pour une stratégie nationale et européenne |

Cédric Villani |

Mars 2018 |

|

Stratégie Nationale de recherche en IA |

Ministère de l’enseignement supérieur, de la recherche et de l’innovation, ministère de l’Économie et des Finances, Direction générale des entreprises, Ministère de la Santé, Ministère des Armées, INRIA, DINSIC |

Novembre 2018 |

|

|

Algorithmes : prévenir l’automatisation des discriminations |

Défenseurs des droits – CNIL |

Mai 2020 |

|

|

Sécurité de l’IA |

CNIL |

Avril 2022 |

|

|

Europe |

Artificial Intelligence for Europe |

Commission Européenne |

Avril 2018 |

|

Lignes directrices en matière d’éthique pour une IA digne de confiance |

Indépendants de haut niveau sur l’intelligence artificielle |

Avril 2019 |

|

|

Renforcer la confiance dans l’intelligence artificielle axée sur le facteur humain |

Commission Européenne |

Avril 2019 |

|

|

Policy and Investment Recommendations for Trustworthy AI |

Indépendants de haut niveau sur l’intelligence artificielle |

Juin 2019 |

|

|

Livre blanc – IA : une approche européenne axée sur l’excellence et la confiance |

Commission Européenne |

Février 2020 |

|

|

AI Act |

Commission Européenne |

Avril 2021 |

|

|

Securing Machine Learning Algorithms |

ENISA |

Novembre 2021 |

|

|

Belgique |

AI 4 Belgium |

AI 4 Belgium Coalition |

Mars 2019 |

|

Luxembourg |

Intelligence artificielle : une vision stratégique pour le Luxembourg |

Digital Luxembourg, Gouvernement du Grand-Duché de Luxembourg |

Mai 2019 |

|

Etats-Unis |

A Vision for Safety 2.0: Automated Driving Systems |

Department of Transportation |

Août 2017 |

|

Preparing for the Future of Transportation: Automated Vehicles 3.0 |

Department of Transportation |

Octobre 2018 |

|

|

The AIM Initiative: A Strategy for Augmenting Intelligence Using Machines |

Department of Defense |

Janvier 2019 |

|

|

Summary of the 2018 Department of Defense Artificial Intelligence Strategy: Harnessing AI to Advance our Security and Prosperity |

Department of Defense |

Février 2019 |

|

|

The National Artificial Intelligence Research and Development Strategic Plan: 2019 Update |

National Science & Technology Council |

Juin 2019 |

|

|

A Plan for Federal Engagement in Developing Technical Standards and Related Tools |

NIST (National Institute of Standards and Technology) |

Août 2019 |

|

|

Ensuring American Leadership in Automated Vehicle Technologies: Automated Vehicles 4.0 |

Department of Transportation |

Janvier 2020 |

|

|

Aiming for truth, fairness, and equity in your company’s use of AI |

Federal trade commission |

Avril 2021 |

|

|

AI Risk Management framework: Initial Draft |

NIST |

Mars 2022 |

|

|

Royaume-Uni |

AI Sector Deal |

Department for Business, Energy & Industrial Strategy; Department for Digital, Culture, Media & Sport |

Mai 2018 |

|

Data Ethics Framework |

Department for Digital, Culture Media & Sport |

Juin 2018 |

|

|

Intelligent security tools: Assessing intelligent tools for cyber security |

National Cyber Security Center |

Avril 2019 |

|

|

Understanding Artificial Intelligence Ethics and Safety |

The Alan Turing Institute |

Juin 2019 |

|

|

Guidelines for AI Procurement |

Office for Artificial Intelligence |

Juin 2020 |

|

|

A guide to using artificial intelligence in the public sector |

Office for Artificial Intelligence |

Janvier 2020 |

|

|

AI Roadmap |

UK AI Council |

Janvier 2021 |

|

|

National AI Strategy |

HM Government |

Septembre 2021 |

|

|

Hong Kong |

High-level Principles on Artificial Intelligence |

Hong Kong Monetary Authority |

Novembre 2019 |

|

Reshaping banking witth Artificial Intelligence |

Hong Kong Monetary Authority |

Décembre 2019 |

|

|

OCDE |

Recommendation of the Council on Artificial Intelligence |

OCDE |

Mai 2019 |

|

Nations Unies |

System-wide Approach and Road map for Supporting Capacity Development on AI |

UN System Chief Executives Board for Coordination |

Juin 2019 |

|

Brésil |

Brazilian Legal Framework for Artificial Intelligence |

Brazilian congress |

Septembre 2021 |

[1] Université d’été qui réunissait des scientifiques comme le célèbre John McCarthy. Cependant, les origines de l’IA peuvent être attribuées à différents chercheurs. Par exemple, dans la littérature, des noms comme celui de l’informaticien Alan Turing peuvent être aussi trouvés.

[2] Par exemple, Amazon a été accusé en octobre 2021 de ne pas respecter l’article 22 du RGPD. Pour plus d’information : https://www.usine-digitale.fr/article/le-fonctionnement-de-l-algorithme-de-paiement-differe-d-amazon-violerait-le-rgpd.N1154412

[3] L’IA n’échappe pas à certaines lois et règlement tels que le RGPD pour les pays concernés. Nous noterons par exemple ce texte de la CNIL : https://www.cnil.fr/fr/intelligence-artificielle/ia-comment-etre-en-conformite-avec-le-rgpd.

[4] A l’exception de propositions législatives comme nous le verrons par la suite pour l’Union Européenne et le Brésil.

[5] Cette liste n’est pas exhaustive. Les chiffres renseignés donnent des ordres de grandeurs sur les principaux publieurs de textes en matière d’encadrement du développement de l’IA.

Les textes sur lesquels s’appuient l’études sont disponibles dans l’annexe 2 page 9

[6] Nous avons fait le choix de fusionner la phase d’identification et de protection pour les besoins de l’article.

[7] National Institute of Standards and Technology (NIST), Framework for improving Critical Infrastructure Cybersecurity, 16 Avril 2018, disponible à https://www.nist.gov/cyberframework/framework

[8] Disponible sur : https://artificialintelligenceact.eu/the-act/

[9] Librement inspiré de : Eve Gaumond, Artificial Intelligence Act: What is the European Approach for AI?, in Lawfare, Juin 2021, disponible sur : https://www.lawfareblog.com/artificial-intelligence-act-what-european-approach-ai

[10] Nous parlons de système pour ne pas réduire l’IA.

[11] https://www.enisa.europa.eu/publications/artificial-intelligence-cybersecurity-challenges

[12] https://www.enisa.europa.eu/publications/securing-machine-learning-algorithms